Open WebUIとのLangfuse統合

Langfuse (GitHub) は、Open WebUI向けのオープンソースの監視と評価を提供しています。Langfuse統合を有効にすると、Open WebUIの使用を開発、監視、改善するためにアプリケーションデータをLangfuseで追跡できるようになります。例として以下が含まれます:

Open WebUIとのLangfuse統合方法

Langfuse統合手順

Langfuse統合手順

Pipelinesは、Open WebUI内でOpenAI APIプラグインのためのUI非依存型フレームワークです。これにより、ユーザーのプロンプトを最終的なLLMに送信する前にプラグインを挿入し、処理や転送が可能になり、プロンプト処理の制御とカスタマイズが強化されます。

アプリケーションデータをLangfuseで追跡するには、Langfuseパイプラインを使用します。これにより、メッセージや対話をリアルタイムでモニタリング・分析することができます。

クイックスタートガイド

ステップ1: Open WebUIのセットアップ

Open WebUIを動作させていることを確認してください。そのためには、Open WebUIドキュメントを参照してください。

ステップ2: Pipelinesのセットアップ

Dockerを使用してPipelinesを起動します。以下のコマンドを使用してPipelinesを開始します:

docker run -p 9099:9099 --add-host=host.docker.internal:host-gateway -v pipelines:/app/pipelines --name pipelines --restart always ghcr.io/open-webui/pipelines:main

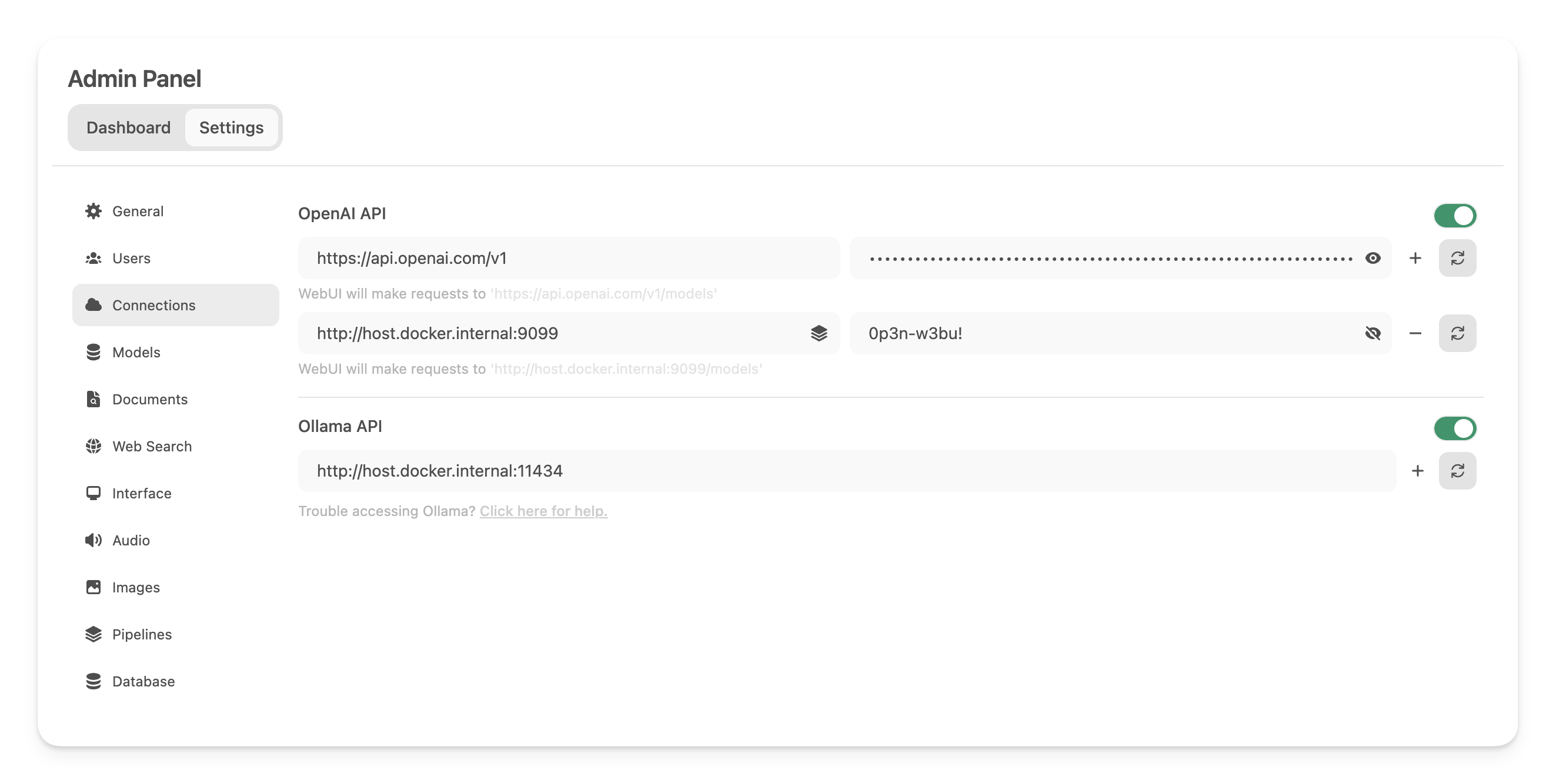

ステップ3: Open WebUIとPipelinesを接続する

_管理設定_で、新しいOpenAI APIタイプの接続を以下の詳細で作成し保存してください:

- URL:

http://host.docker.internal:9099(以前起動したDockerコンテナが動いている場所です)。 - パスワード: 0p3n-w3bu! (標準パスワード)

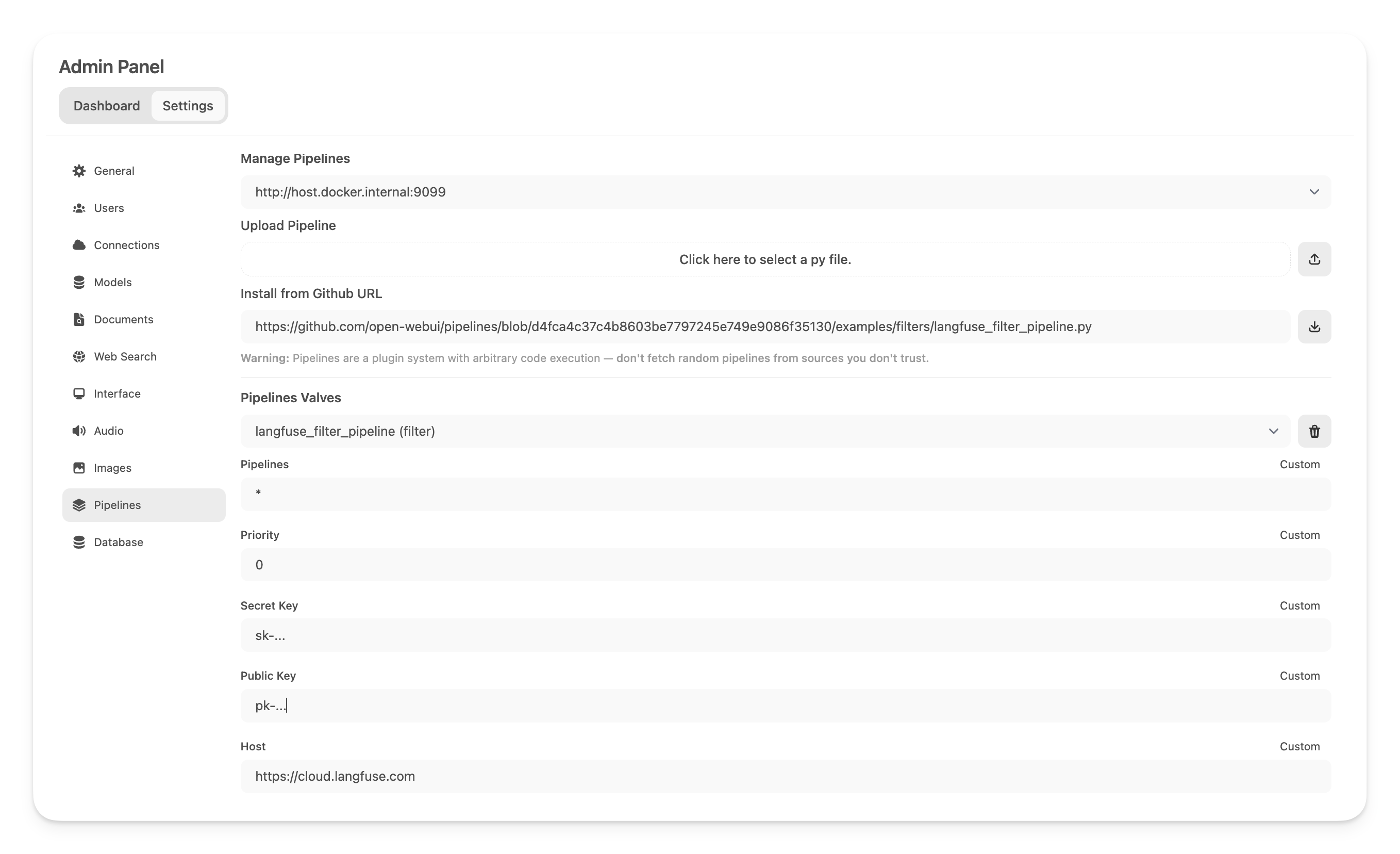

ステップ4: Langfuseフィルターパイプラインの追加

次に、管理設定 -> Pipelines_に移動し、Langfuseフィルターパイプラインを追加します。Pipelinesが以前設定されたhttp://host.docker.internal:9099で待機していることを指定し、以下のURLで[GitHub URLからインストール]_オプションを使用してLangfuseフィルターパイプラインをインストールします:

https://github.com/open-webui/pipelines/blob/main/examples/filters/langfuse_filter_pipeline.py

次にLangfuseのAPIキーをここに追加してください。まだLangfuseにサインアップしていない場合は、こちらでアカウントを作成してAPIキーを取得できます。

注: OpenAiモデルのストリーミングが有効な状態で、使用状況(トークンカウント)をキャプチャするには、Open WebUIのモデル設定に移動し、下の_機能_セクションの"使用状況"ボックスをチェックしてください。

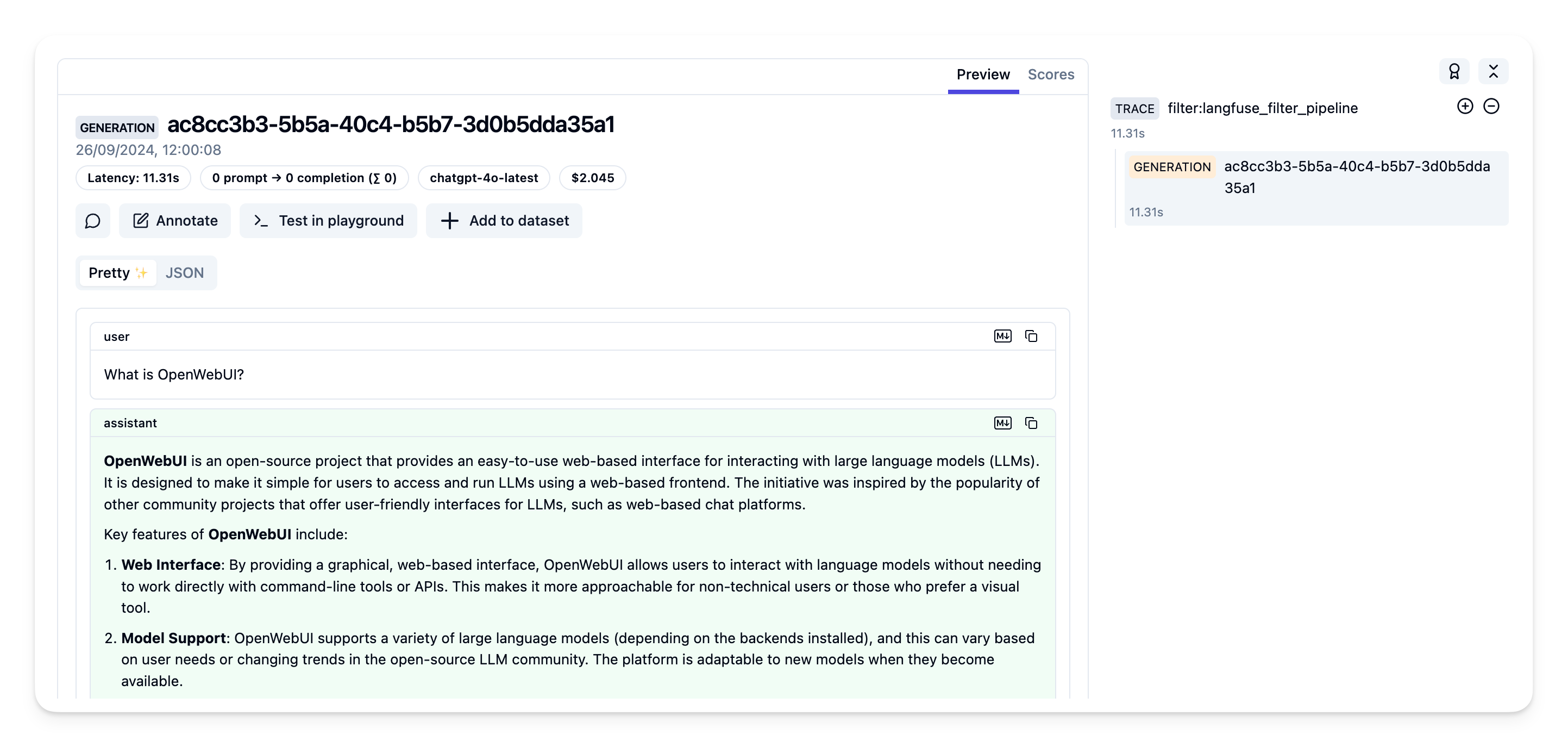

ステップ5: Langfuseでトレースを確認する

これでOpen WebUIアプリケーションと対話できるようになり、Langfuseでトレースを確認できます。

詳細情報

Open WebUI Pipelinesに関する詳細なガイドについては、こちらの記事をご覧ください。