このチュートリアルはコミュニティによる貢献であり、Open WebUIチームによるサポートは提供されていません。特定の使用ケースに合わせてOpen WebUIをカスタマイズする方法を示す目的のみで提供されています。貢献したいですか?貢献ガイドをチェックしてください。

このガイドは手動インストールを通じてOpen WebUIをセットアップする場合に検証済みです。

Intel GPU上でIPEX-LLMを使用したローカルLLMセットアップ

IPEX-LLMは、Intel CPUおよびGPU(例:iGPUを持つローカルPC、Arc AシリーズのようなディスクリートGPU、Flex、Max)でLLMを非常に低遅延で実行するためのPyTorchライブラリです。

このチュートリアルでは、Intel GPU上でホストされるIPEX-LLM加速Ollamaバックエンドを使用してOpen WebUIをセットアップする方法を示します。このガイドに従うことで、低コストのPC(統合GPUのみ)でもスムーズな体験でOpen WebUIをセットアップできるようになります。

Intel GPUでOllama Serveを起動

Intel GPU上でIPEX-LLMにより加速されたOllama serveをインストールし実行する方法については、IPEX-LLM公式ドキュメントのこのガイドを参照してください。

別のマシンからOllamaサービスにアクセスしたい場合、コマンドollama serveを実行する前に環境変数OLLAMA_HOST=0.0.0.0を設定またはエクスポートしてください。

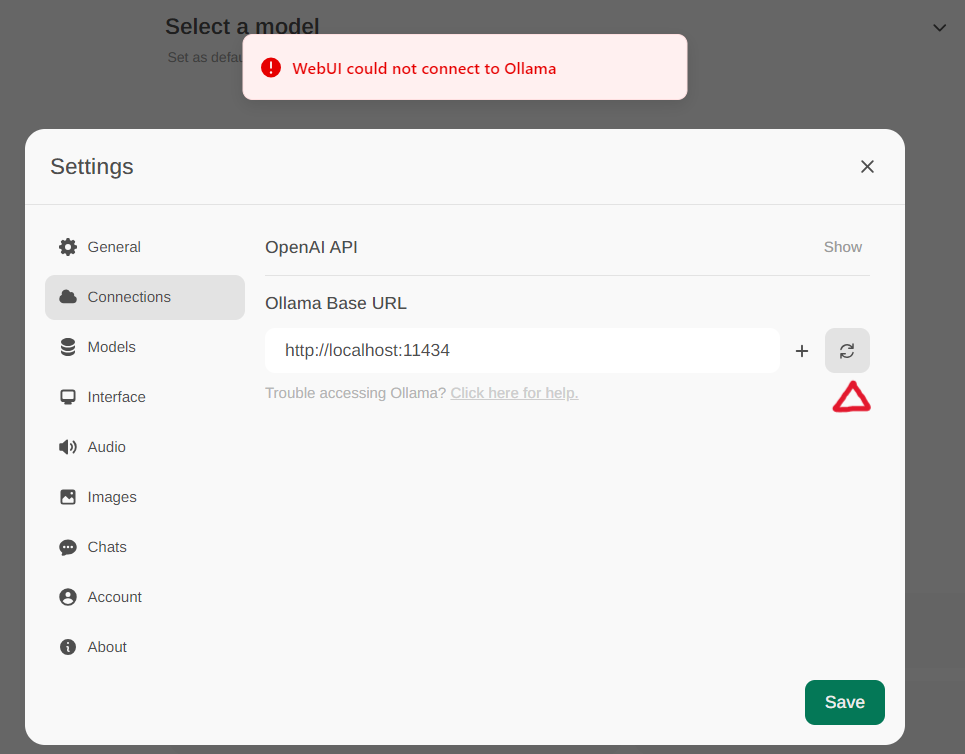

Open WebUIを構成

メニューの設定 -> 接続を通じてOllama設定にアクセスします。デフォルトでは、Ollama Base URL はhttps://localhost:11434に設定されています。以下のスナップショットに示されています。Ollamaサービス接続のステータスを確認するには、テキストボックスの横にある更新ボタンをクリックします。WebUIがOllamaサーバーとの接続を確立できない場合、WebUI could not connect to Ollamaというエラーメッセージが表示されます。

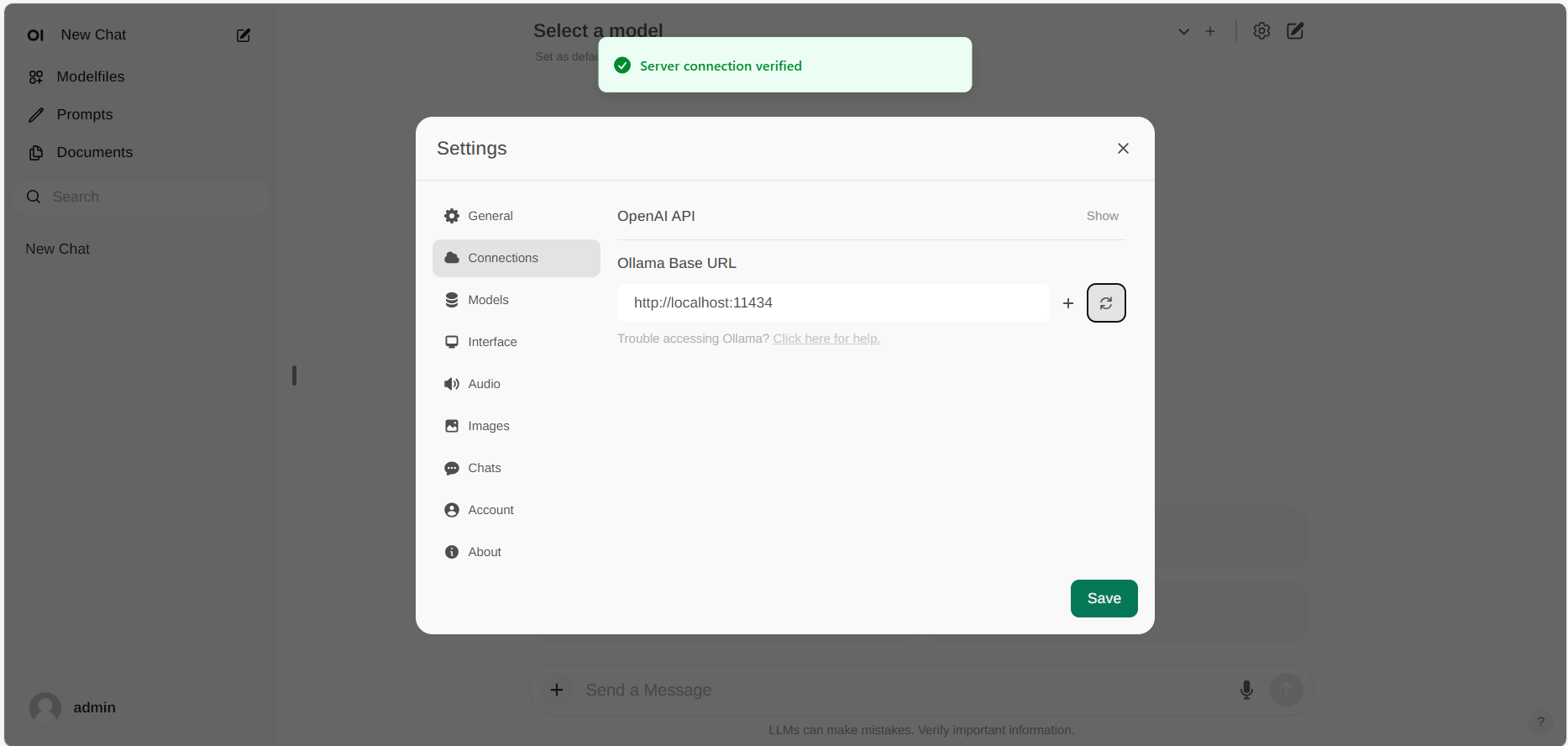

接続が成功すると、以下に示されているようにService Connection Verifiedというメッセージが表示されます。

異なるURLでホストされているOllamaサーバーを使用したい場合は、単にOllama Base URLを新しいURLに更新し、接続を再確認するために更新ボタンを押してください。