Этот урок является вкладом сообщества и не поддерживается командой Open WebUI. Он предназначен только для демонстрации того, как настроить Open WebUI для вашего конкретного сценария использования. Хотите внести свой вклад? Ознакомьтесь с руководством по вкладу.

Это руководство проверено на установке Open WebUI через руководство по ручной установке.

Настройка локальной LLM с IPEX-LLM на Intel GPU

IPEX-LLM — это библиотека PyTorch для запуска LLM на Intel CPU и GPU (например, на локальном ПК с iGPU, дискретным GPU, таким как Arc A-Series, Flex и Max) с очень низкой задержкой.

В этом уроке демонстрируется, как настроить Open WebUI с ускоренным IPEX-LLM бэкэндом Ollama, размещённым на Intel GPU. Следуя этому руководству, вы сможете настроить Open WebUI даже на доступном ПК (например, только с интегрированным GPU) с плавным пол�ьзовательским опытом.

Запуск Ollama Serve на Intel GPU

Обратитесь к этому руководству из официальной документации IPEX-LLM о том, как установить и запустить Ollama serve, ускоренный с помощью IPEX-LLM на Intel GPU.

Если вы хотите получить доступ к службе Ollama с другого устройства, убедитесь, что вы установили или экспортировали переменную окружения OLLAMA_HOST=0.0.0.0 перед выполнением команды ollama serve.

Настро�йка Open WebUI

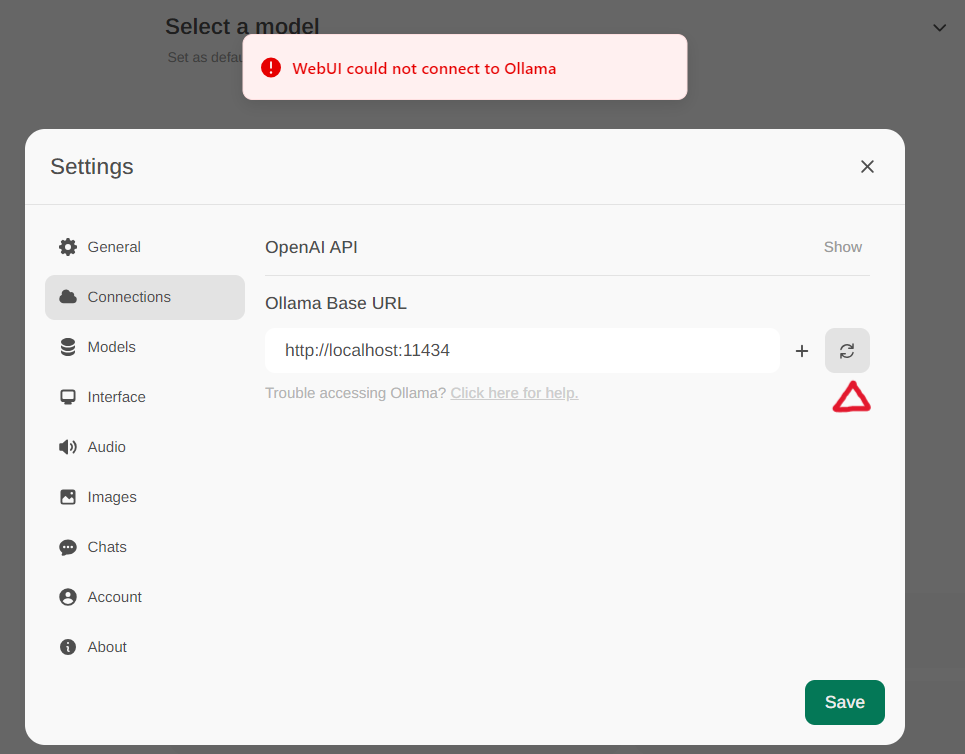

Получите доступ к настройкам Ollama через Настройки -> Подключения в меню. По умолчанию Базовый URL Ollama установлен на https://localhost:11434, как показано на снимке ниже. Для проверки статуса подключения к службе Ollama нажмите Кнопку обновления, расположенную рядом с текстовым полем. Если WebUI не удаётся установить соединение с сервером Ollama, вы увидите сообщение об ошибке: WebUI не удалось подключиться к Ollama.

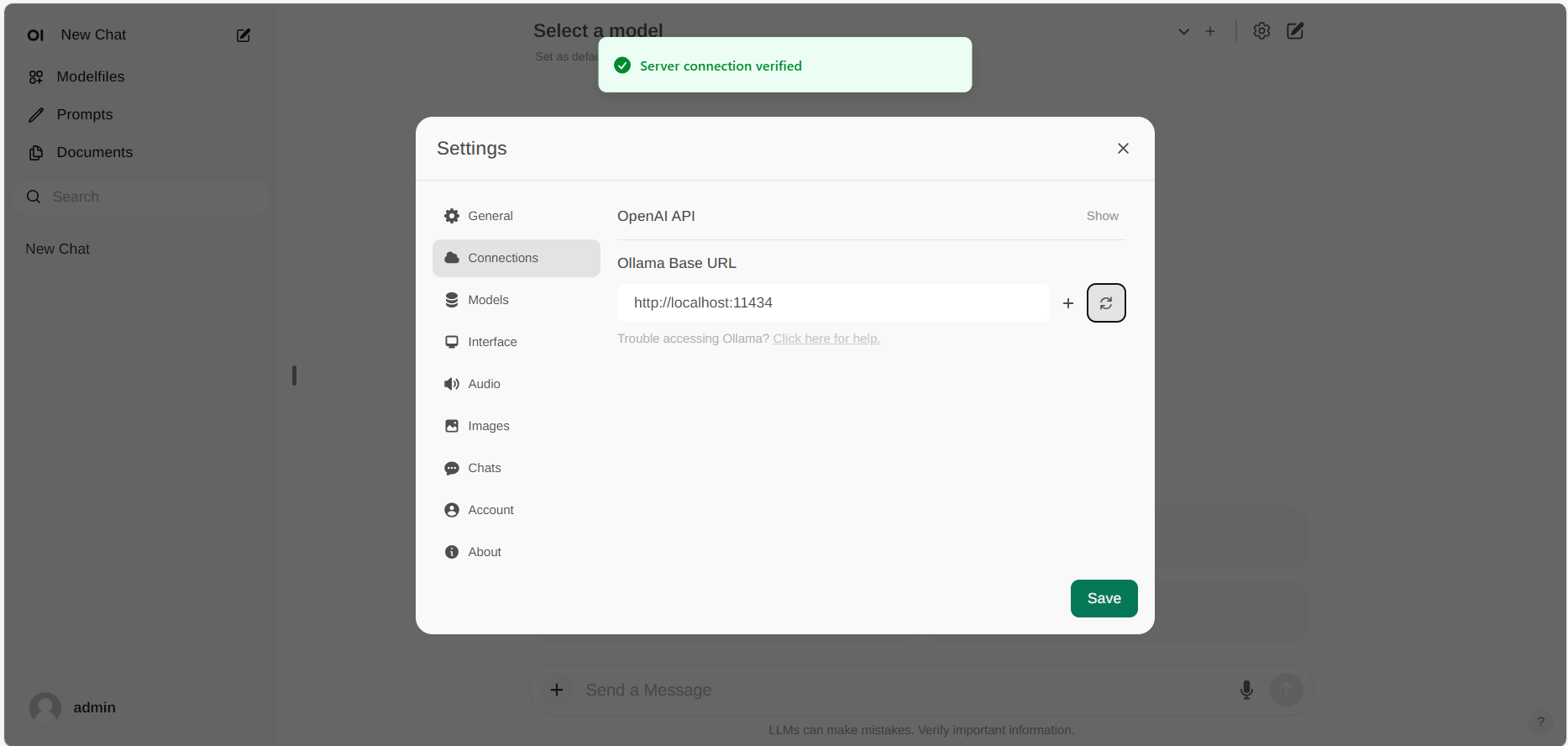

Если подключение успешно, вы увидите сообщение: Подключение к сервису подтверждено, как показано ниже.

Если вы хотите использовать сервер Ollama, размещённый по другому URL, просто обновите Базовый URL Ollama на новый URL и нажмите Обновить, чтобы повторно подтвердить подключение к Ollama.