Интеграция Langfuse с Open WebUI

Langfuse (GitHub) предлагает решения для наблюдаемости и оценки качества с открытым исходным кодом для Open WebUI. Включив интеграцию с Langfuse, вы можете отслеживать данные вашего приложения с помощью Langfuse для разработки, мониторинга и улучшения использования Open WebUI, включая:

- Трассировки приложений

- Паттерны использования

- Данные о стоимости по пользователю и модели

- Повторение сессий для поиска и исправления ошибок

- Оценки

Как интегрировать Langfuse с Open WebUI

Шаги интеграции Langfuse

Шаги интеграции Langfuse

Pipelines в Open WebUI — это фреймворк, независимый от пользовательского интерфейса, для плагинов OpenAI API. Он позволяет внедрение плагинов, которые перехватывают, обрабатывают и перенаправляют пользовательские запросы в конечную языковую модель (LLM), обеспечивая расширенный контроль и настройку работы с запросами.

Чтобы отслеживать данные вашего приложения с Langfuse, вы можете использовать конвейер Langfuse, который позволяет в режиме реального времени мониторить и анализировать взаимодействия сообщений.

Краткое руководство по началу работы

Шаг 1: Настройка Open WebUI

Убедитесь, что Open WebUI запущен. Для этого ознакомьтесь с документацией Open WebUI.

Шаг 2: Настройка Pipelines

Запустите Pipelines с помощью Docker. Используйте следующую команду для запуска Pipelines:

docker run -p 9099:9099 --add-host=host.docker.internal:host-gateway -v pipelines:/app/pipelines --name pipelines --restart always ghcr.io/open-webui/pipelines:main

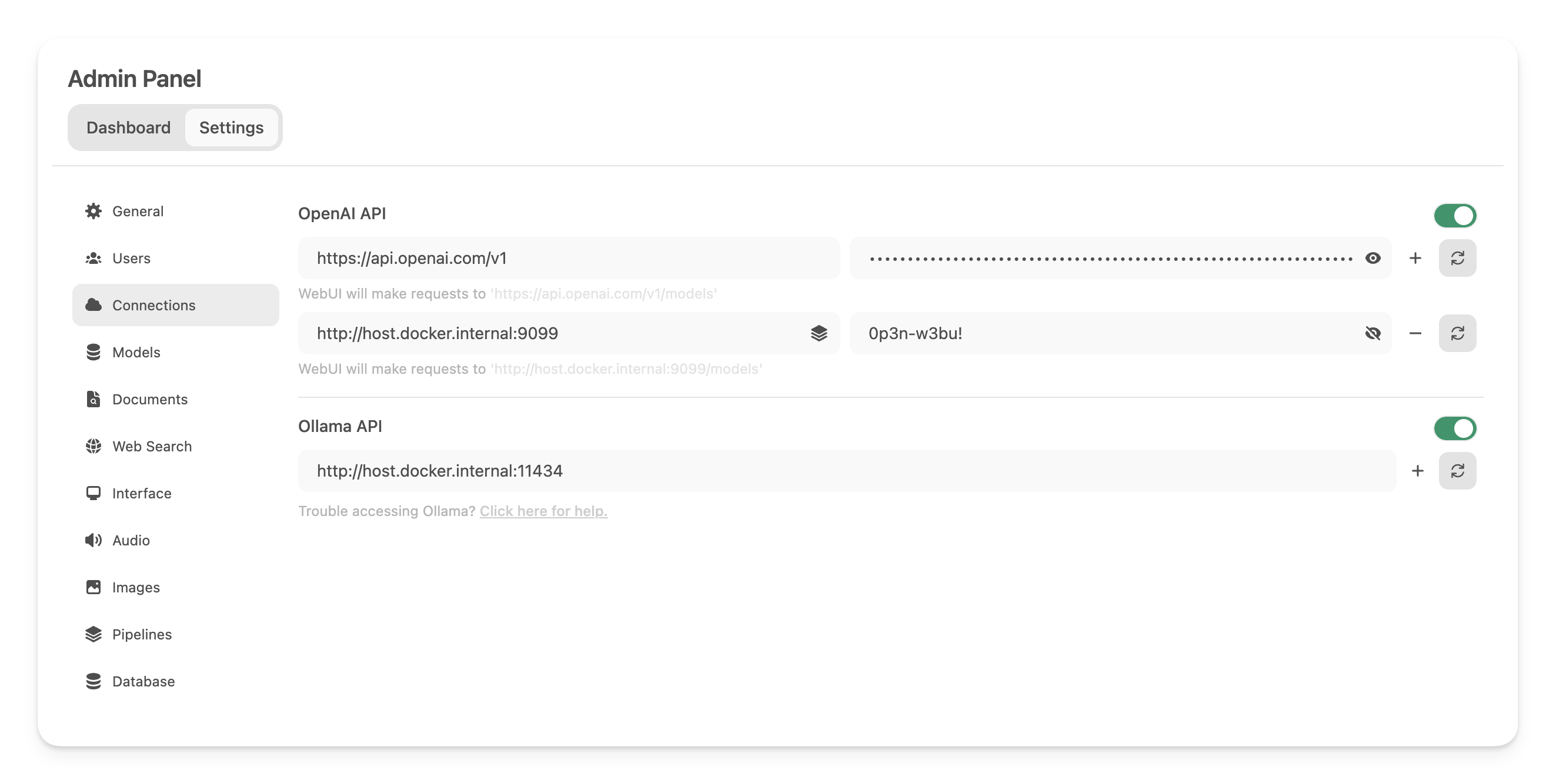

Шаг 3: Соединение Open WebUI с Pipelines

В Настройках администратора создайте новое соединение типа OpenAI API и сохраните его с следующими данными:

- URL:

http://host.docker.internal:9099(это адрес ранее запущенного Docker контейнера). - Пароль: 0p3n-w3bu! (стандартный пароль)

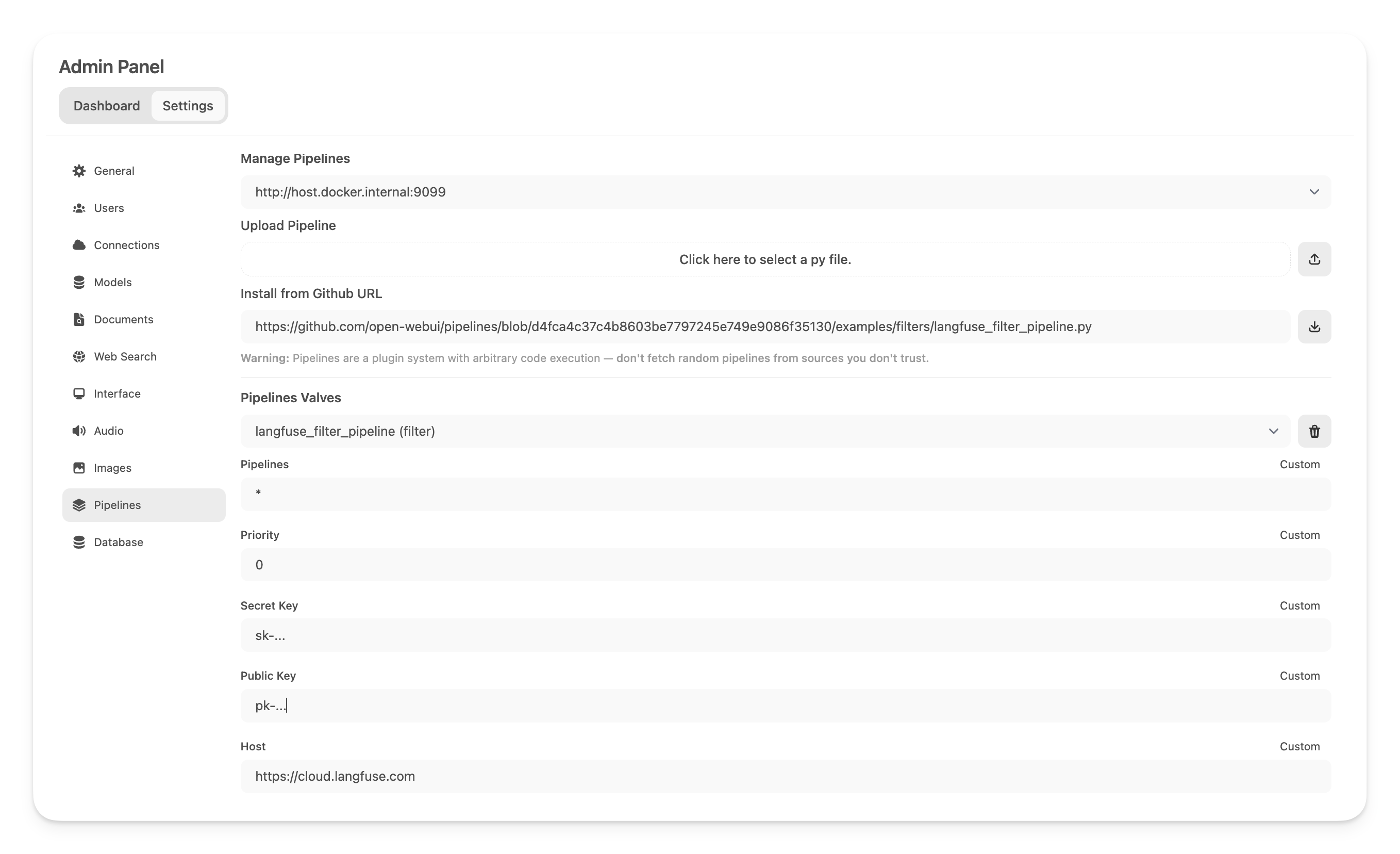

Шаг 4: Добавление Langfuse Filter Pipeline

Далее, перейдите в Настройки администратора -> Pipelines и добавьте Langfuse Filter Pipeline. Укажите, что Pipelines слушает наhttp://host.docker.internal:9099 (как было настроено ранее) и установите Langfuse Filter Pipeline, используя опцию Install from Github URL с следующим URL:

https://github.com/open-webui/pipelines/blob/main/examples/filters/langfuse_filter_pipeline.py

Теперь добавьте ваши API-ключи Langfuse ниже. Если вы еще не зарегистрировались в Langfuse, вы можете получить свои API-ключи, создав а�ккаунт здесь.

Примечание: Чтобы фиксировать использование (количество токенов) для моделей OpenAi при включенной потоковой передаче, вам нужно перейти в настройки модели в Open WebUI и отметить поле "Usage" ссылку ниже пункта Capabilities.

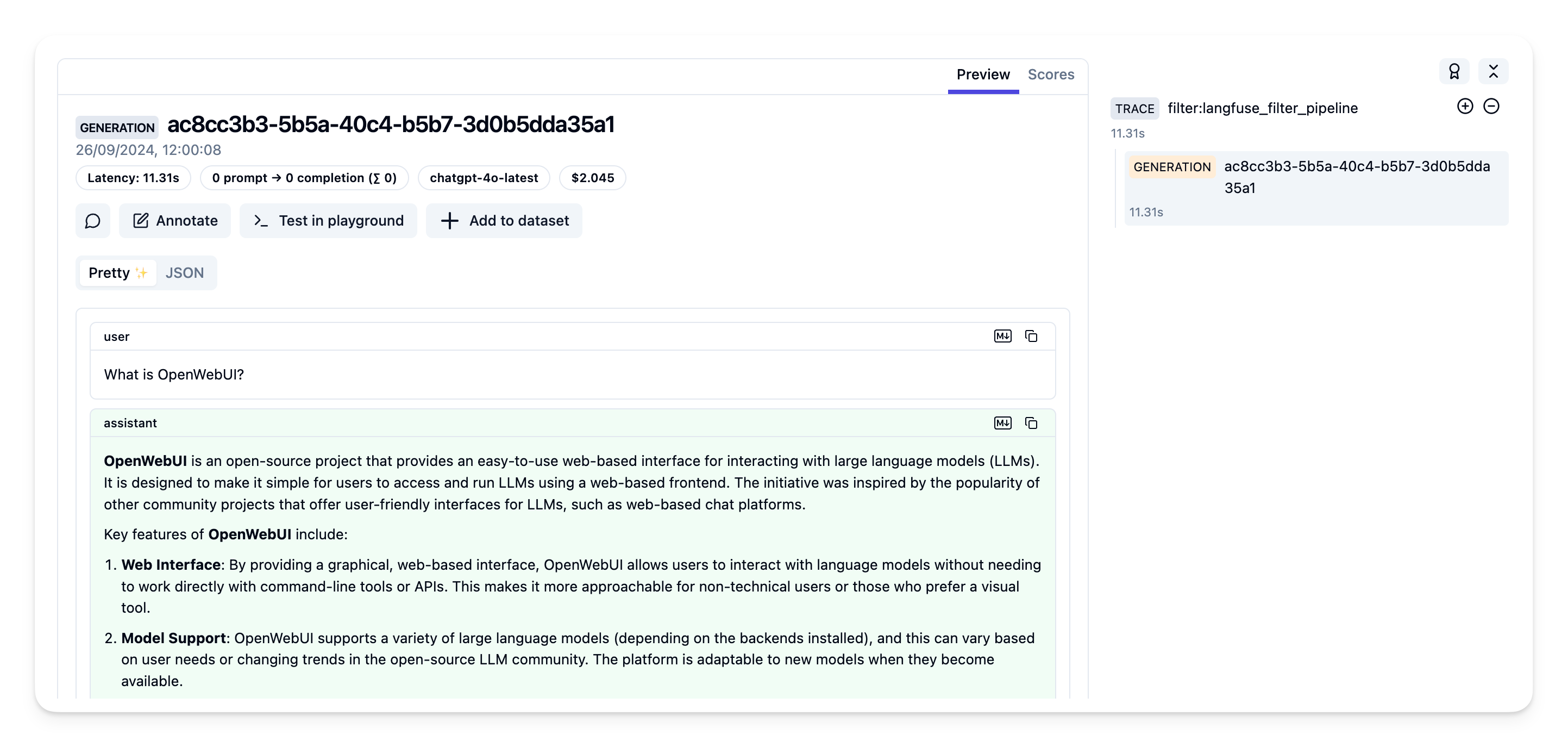

Шаг 5: Просмотр трассировок в Langfuse

Теперь вы можете взаимодействовать с вашим приложением Open WebUI и видеть трассировки в Langfuse.

Пример трассировки в интерфейсе Langfuse:

Узнайте больше

Для получения полного руководства о Pipelines в Open WebUI посетите этот пост.