Intégration de Langfuse avec Open WebUI

Langfuse (GitHub) offre une observabilité et des évaluations open source pour Open WebUI. En activant l'intégration Langfuse, vous pouvez tracer les données de votre application avec Langfuse pour développer, surveiller et améliorer l'utilisation d'Open WebUI, y compris :

- Traces de l'application

- Modèles d'utilisation

- Données de coût par utilisateur et modèle

- Sessions de relecture pour déboguer les problèmes

- Évaluations

Comment intégrer Langfuse avec Open WebUI

Étapes d'intégration de Langfuse

Étapes d'intégration de Langfuse

Pipelines dans Open WebUI est un cadre agnostique de l'interface utilisateur pour les plugins OpenAI API. Il permet l'injection de plugins qui interceptent, traitent et transmettent les invites des utilisateurs au modèle linguistique final, offrant un contrôle et une personnalisation renforcés de la gestion des invites.

Pour tracer vos données d'application avec Langfuse, vous pouvez utiliser le pipeline Langfuse, qui permet une surveillance et une analyse en temps réel des interactions de messages.

Guide de démarrage rapide

Étape 1 : Configuration d'Open WebUI

Assurez-vous qu'Open WebUI est en cours d'exécution. Pour ce faire, consultez la documentation Open WebUI.

Étape 2 : Configuration des Pipelines

Lancez Pipelines en utilisant Docker. Utilisez la commande suivante pour démarrer les Pipelines :

docker run -p 9099:9099 --add-host=host.docker.internal:host-gateway -v pipelines:/app/pipelines --name pipelines --restart always ghcr.io/open-webui/pipelines:main

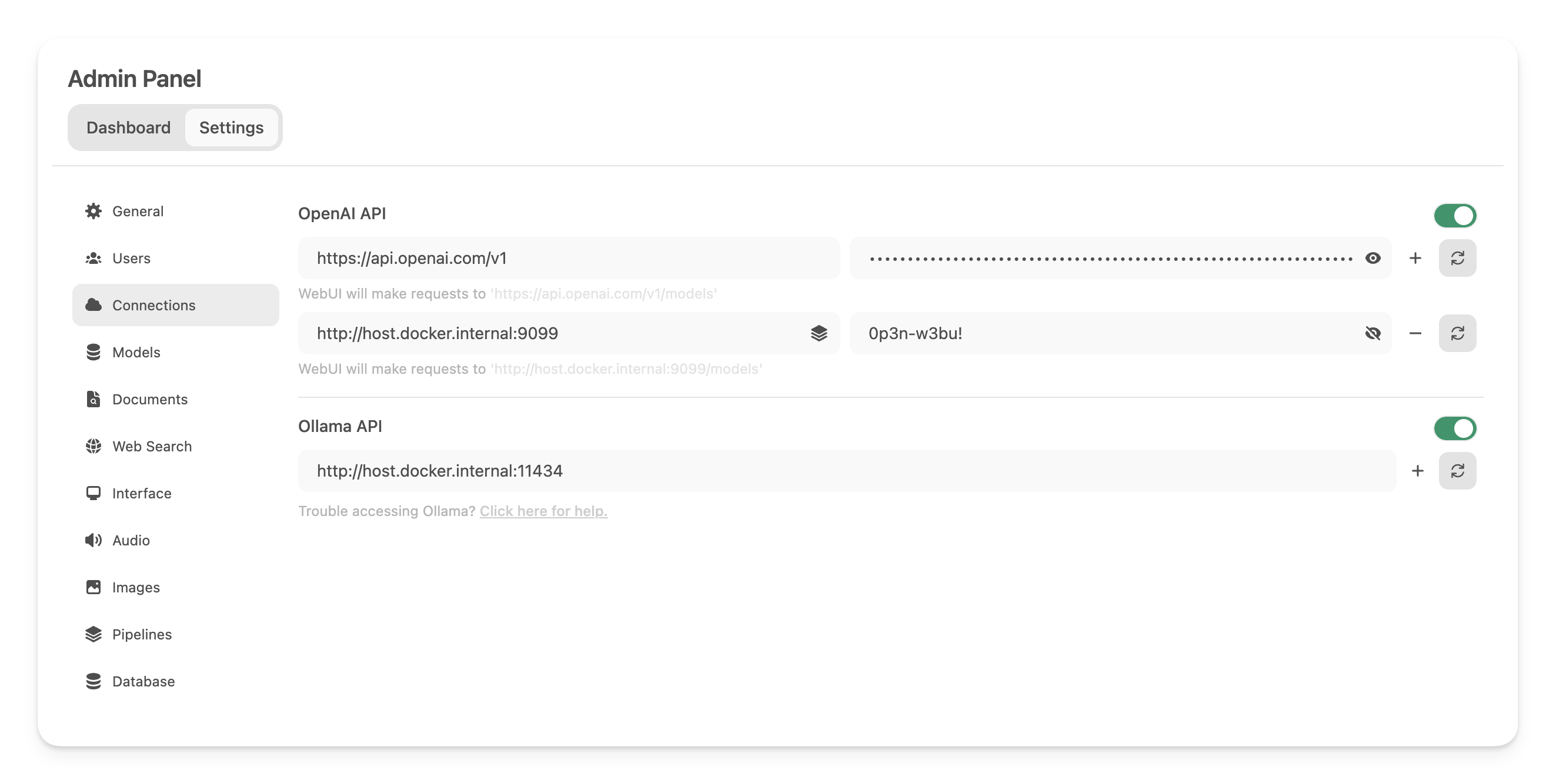

Étape 3 : Connecter Open WebUI aux Pipelines

Dans les Paramètres Administratifs, créez et enregistrez une nouvelle connexion de type API OpenAI avec les détails suivants :

- URL :

http://host.docker.internal:9099(c'est là que le conteneur Docker lancé précédemment s'exécute). - Mot de passe : 0p3n-w3bu! (mot de passe standard)

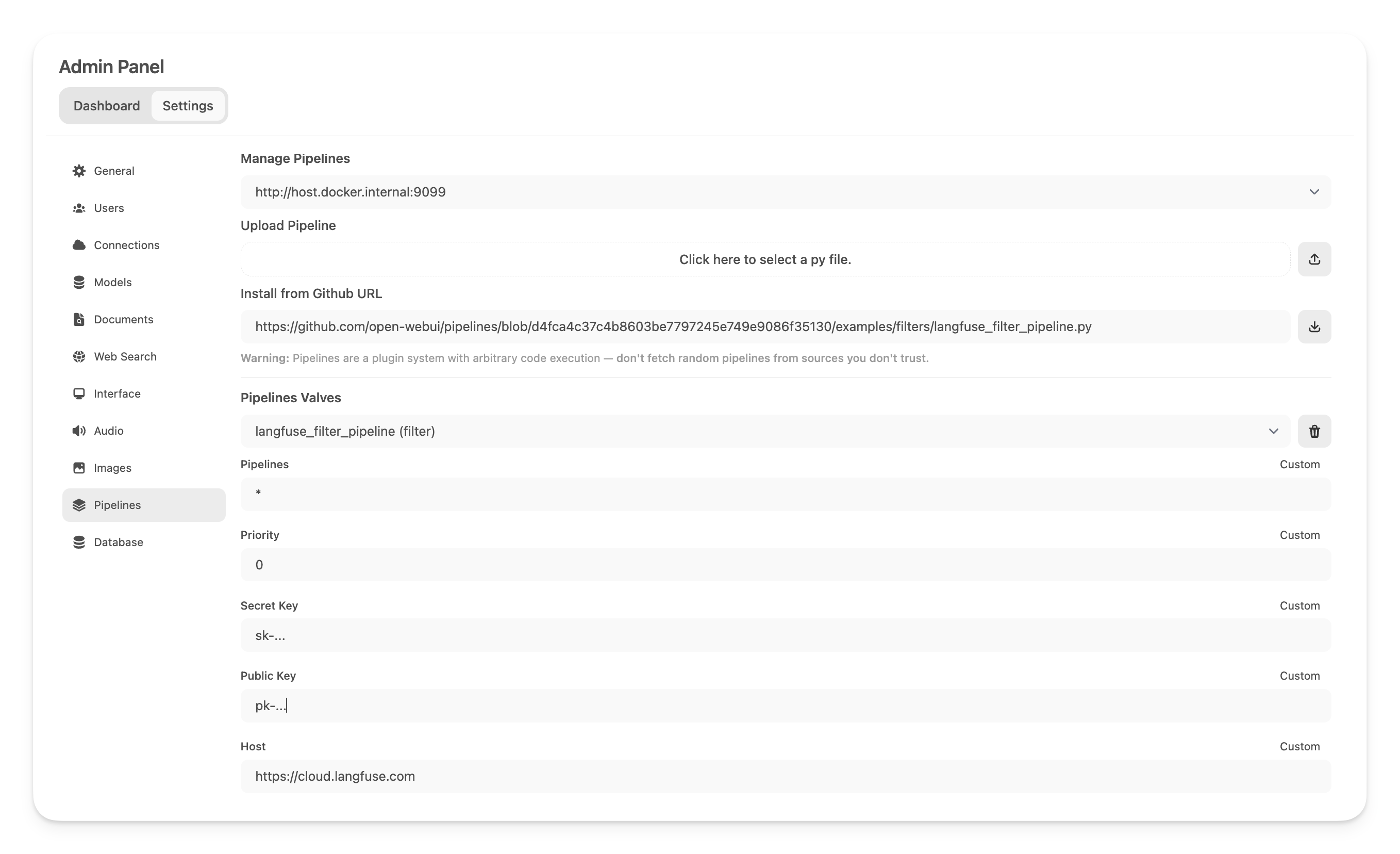

Étape 4 : Ajouter le pipeline de filtre Langfuse

Ensuite, dans les Paramètres Administratifs -> Pipelines, ajoutez le pipeline de filtre Langfuse. Spécifiez que Pipelines écoute surhttp://host.docker.internal:9099 (comme configuré précédemment) et installez le pipeline de filtre Langfuse en utilisant l'option Install from Github URL avec l'URL suivante :

https://github.com/open-webui/pipelines/blob/main/examples/filters/langfuse_filter_pipeline.py

Ajoutez ensuite vos clés API Langfuse ci-dessous. Si vous ne vous êtes pas encore inscrit à Langfuse, vous pouvez obtenir vos clés API en créant un compte ici.

Note : Pour capturer l'utilisation (décompte de tokens) des modèles OpenAI tout en activant le streaming, vous devez naviguer vers les paramètres du modèle dans Open WebUI et cocher la case "Usage" ci-dessous Capacités.

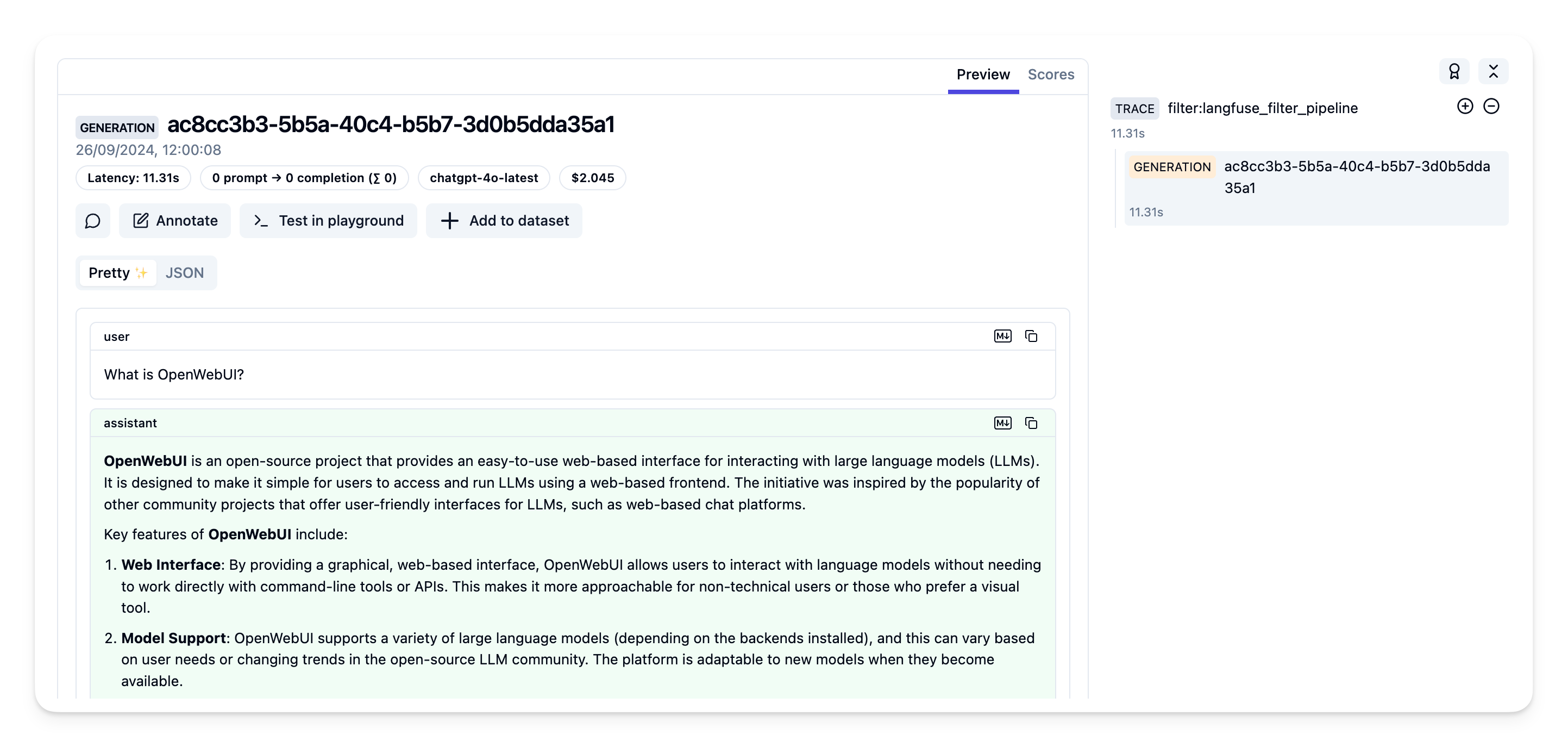

Étape 5 : Voir vos traces dans Langfuse

Vous pouvez maintenant interagir avec votre application Open WebUI et voir les traces dans Langfuse.

Exemple de trace dans l'interface Langfuse :

En savoir plus

Pour un guide complet sur les Pipelines Open WebUI, consultez ce post.