Langfuse-Integration mit Open WebUI

Langfuse (GitHub) bietet Open-Source-Observabilität und Bewertungen für Open WebUI. Durch Aktivieren der Langfuse-Integration können Sie Ihre Anwendungsdaten mit Langfuse verfolgen, um die Nutzung von Open WebUI zu entwickeln, zu überwachen und zu verbessern, einschließlich:

- Anwendungs-Traces

- Nutzungsmuster

- Kostendaten nach Benutzer und Modell

- Sitzungswiedergaben zur Fehlerbehebung

- Bewertungen

So integrieren Sie Langfuse mit Open WebUI

Schritte zur Langfuse-Integration

Schritte zur Langfuse-Integration

Pipelines in Open WebUI ist ein UI-unabhängiges Framework für OpenAI API-Plugins. Es ermöglicht die Einspeisung von Plugins, die Benutzereingaben überwachen, verarbeiten und an das endgültige LLM weiterleiten, was zu erweitertem Steuerungs- und Anpassungsvermögen bei der Eingabeverarbeitung führt.

Um Ihre Anwendungsdaten mit Langfuse zu verfolgen, können Sie die Langfuse-Pipeline verwenden, die Echtzeitüberwachung und Analyse von Nachrichteninteraktionen ermöglicht.

Schnellstart-Anleitung

Schritt 1: Open WebUI einrichten

Stellen Sie sicher, dass Open WebUI läuft. Sehen Sie sich dazu die Open WebUI-Dokumentation an.

Schritt 2: Pipelines einrichten

Starten Sie Pipelines mithilfe von Docker. Verwenden Sie den folgenden Befehl, um Pipelines zu starten:

docker run -p 9099:9099 --add-host=host.docker.internal:host-gateway -v pipelines:/app/pipelines --name pipelines --restart always ghcr.io/open-webui/pipelines:main

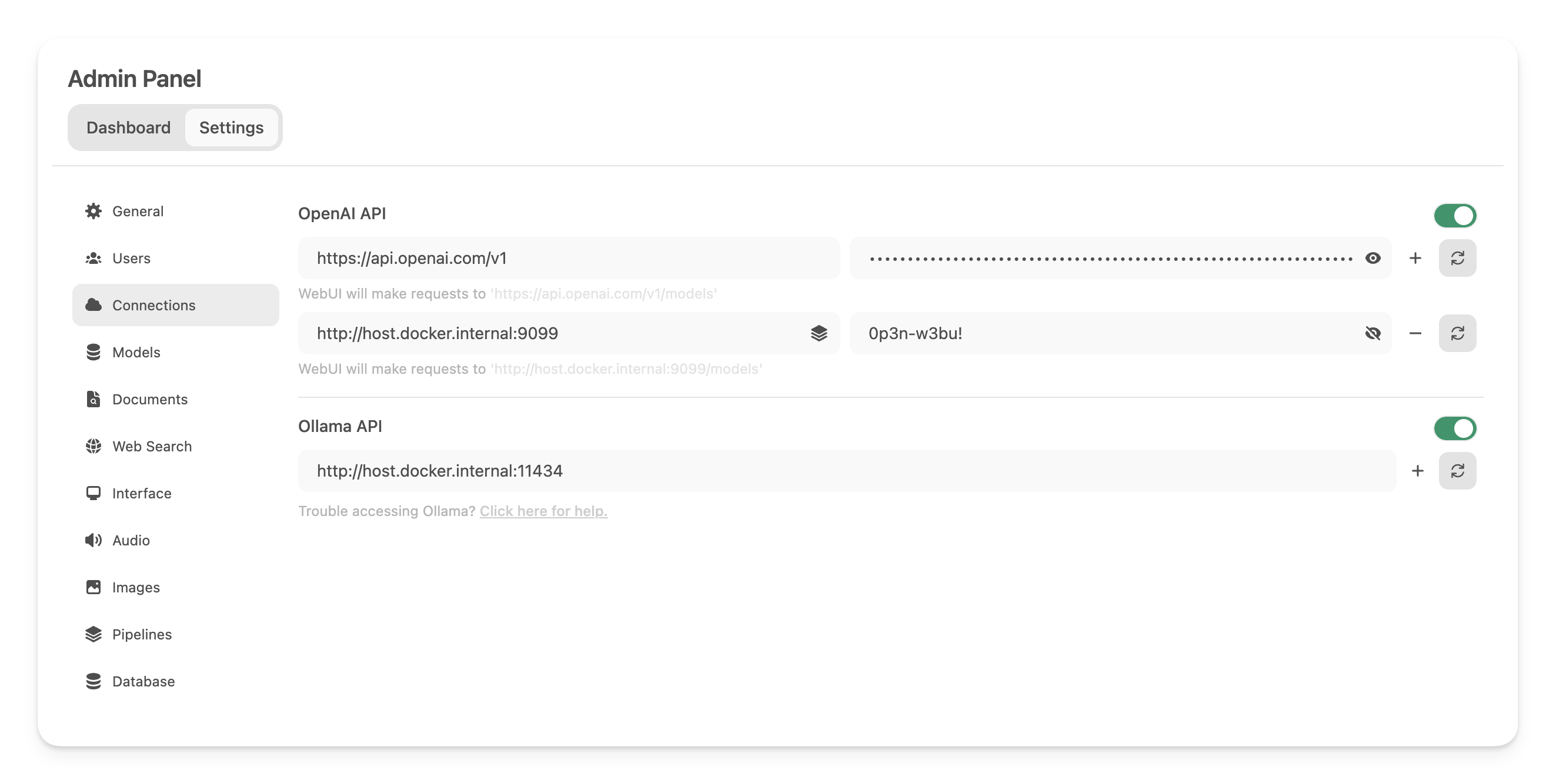

Schritt 3: Verbindung von Open WebUI mit Pipelines

Erstellen und speichern Sie unter Admin-Einstellungen eine neue Verbindung des Typs OpenAI API mit den folgenden Details:

- URL:

http://host.docker.internal:9099(hier wird der zuvor gestartete Docker-Container ausgeführt). - Passwort: 0p3n-w3bu! (Standard-Passwort)

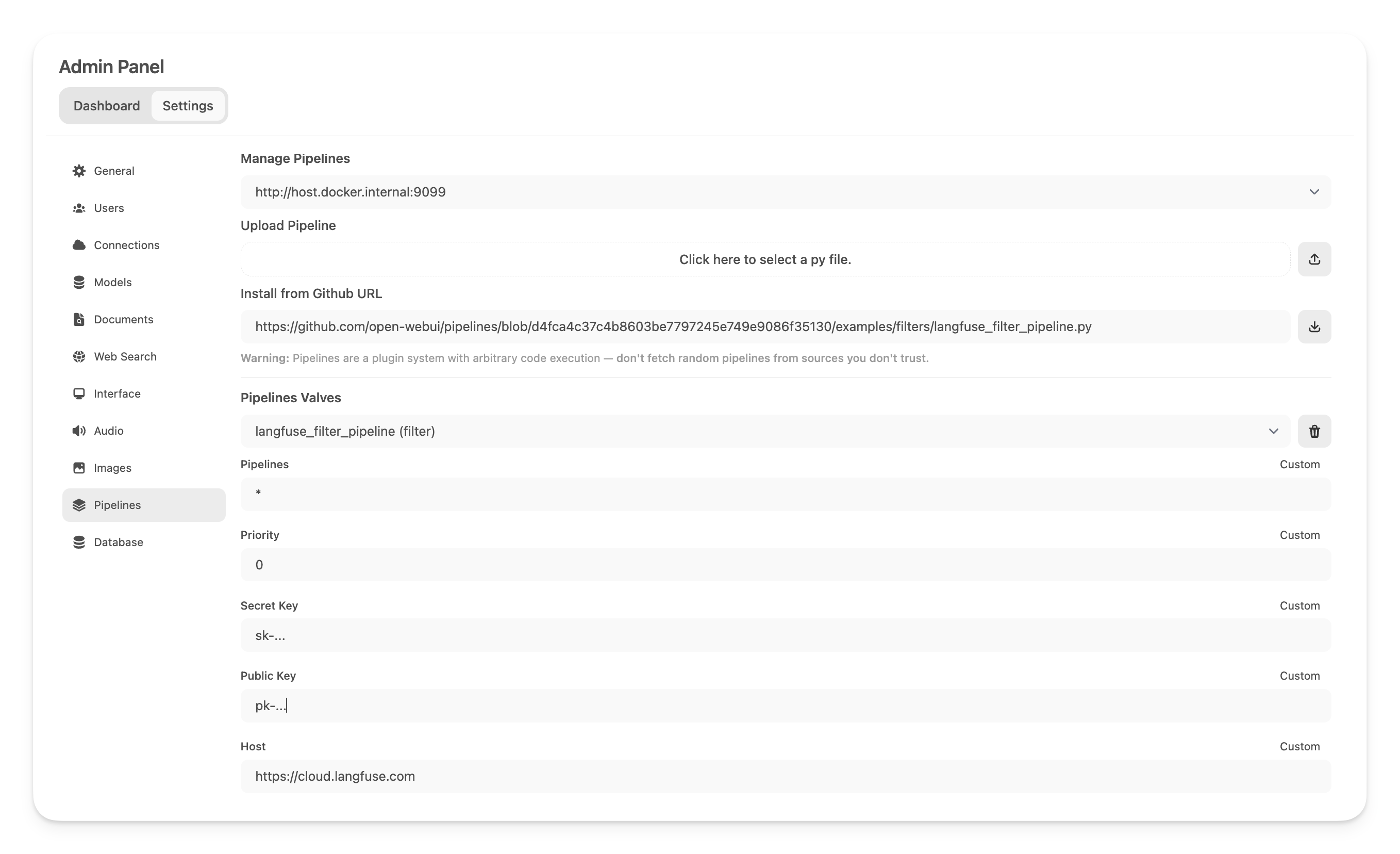

Schritt 4: Langfuse Filter Pipeline hinzufügen

Navigieren Sie als Nächstes zu Admin-Einstellungen -> Pipelines und fügen Sie die Langfuse Filter Pipeline hinzu. Geben Sie an, dass Pipelines unterhttp://host.docker.internal:9099 (wie zuvor konfiguriert) lauschen und installieren Sie die Langfuse Filter Pipeline über die Option Von Github-URL installieren mit der folgenden URL:

https://github.com/open-webui/pipelines/blob/main/examples/filters/langfuse_filter_pipeline.py

Fügen Sie nun Ihre Langfuse-API-Schlüssel unten ein. Wenn Sie sich noch nicht bei Langfuse angemeldet haben, können Sie Ihre API-Schlüssel erhalten, indem Sie hier ein Konto erstellen.

Hinweis: Um die Nutzung (Token-Zählungen) für OpenAI-Modelle zu erfassen, während Streaming aktiviert ist, navigieren Sie zu den Modelleinstellungen in Open WebUI und aktivieren Sie das "Usage"-Feld unter Capabilities.

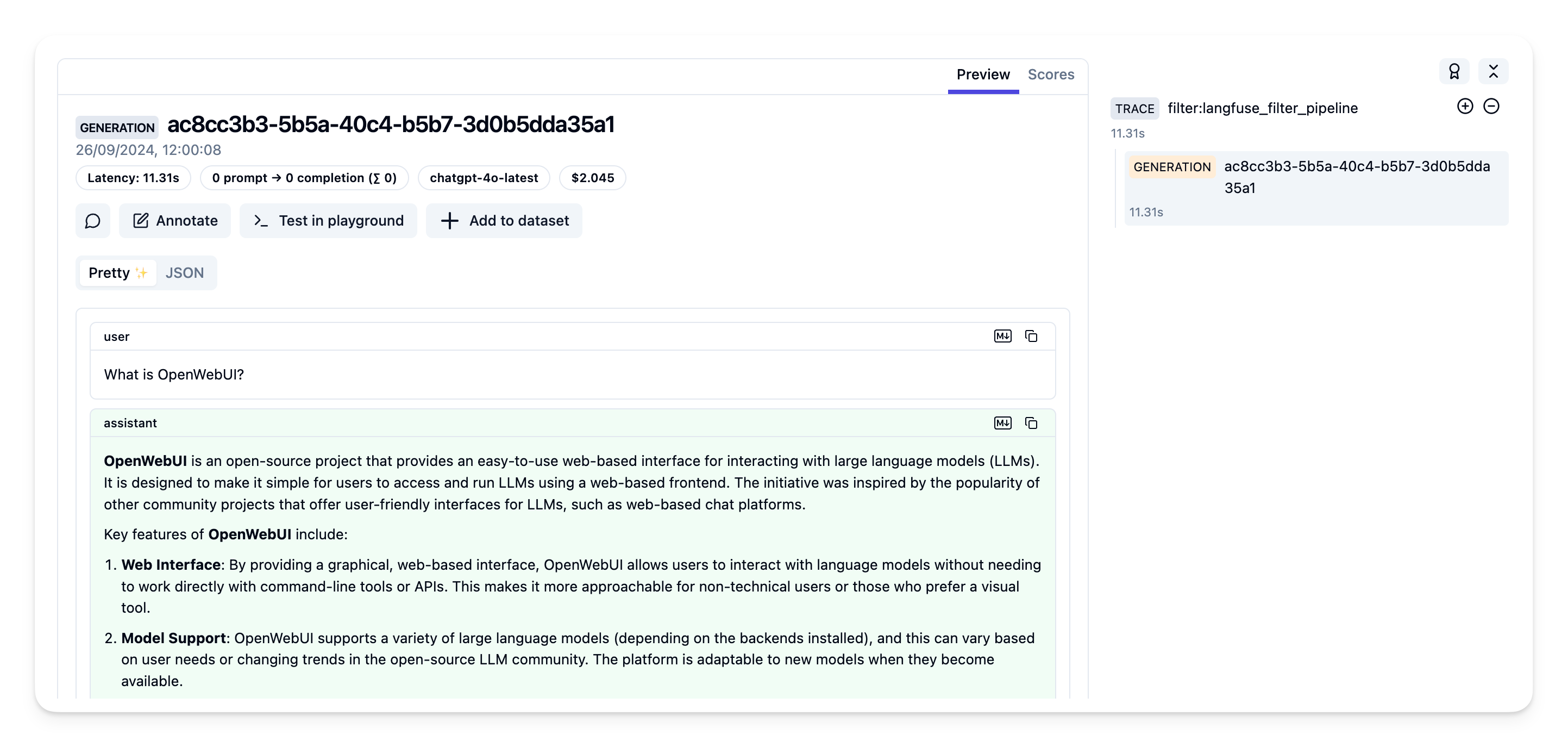

Schritt 5: Ihre Traces in Langfuse anzeigen

Sie können jetzt mit Ihrer Open WebUI-Anwendung interagieren und die Traces in Langfuse anzeigen.

Beispiel-Trace in der Langfuse-Oberfläche:

Mehr erfahren

Für eine umfassende Anleitung zu Open WebUI Pipelines besuchen Sie diesen Beitrag.