Integração do Langfuse com Open WebUI

Langfuse (GitHub) oferece observabilidade e avaliações de código aberto para Open WebUI. Ao ativar a integração com Langfuse, você pode rastrear os dados do seu aplicativo com Langfuse para desenvolver, monitorar e melhorar o uso do Open WebUI, incluindo:

- Rastreamentos de aplicação

- Padrões de uso

- Dados de custo por usuário e modelo

- Sessões de replay para depuração de problemas

- Avaliações

Como integrar Langfuse com Open WebUI

Etapas de integração do Langfuse

Etapas de integração do Langfuse

Pipelines no Open WebUI é uma estrutura independente de interface para plugins da API OpenAI. Ele permite a injeção de plugins que interceptam, processam e encaminham os prompts dos usuários para o LLM final, proporcionando maior controle e personalização no processamento de prompts.

Para rastrear os dados do seu aplicativo com Langfuse, você pode usar o pipeline do Langfuse, que permite monitoramento e análise em tempo real das interações de mensagens.

Guia Rápido

Passo 1: Configurar Open WebUI

Certifique-se de que o Open WebUI esteja em execução. Para isso, consulte a documentação do Open WebUI.

Passo 2: Configurar Pipelines

Inicie o Pipelines usando Docker. Use o comando abaixo para iniciar o Pipelines:

docker run -p 9099:9099 --add-host=host.docker.internal:host-gateway -v pipelines:/app/pipelines --name pipelines --restart always ghcr.io/open-webui/pipelines:main

Passo 3: Conectar Open WebUI ao Pipelines

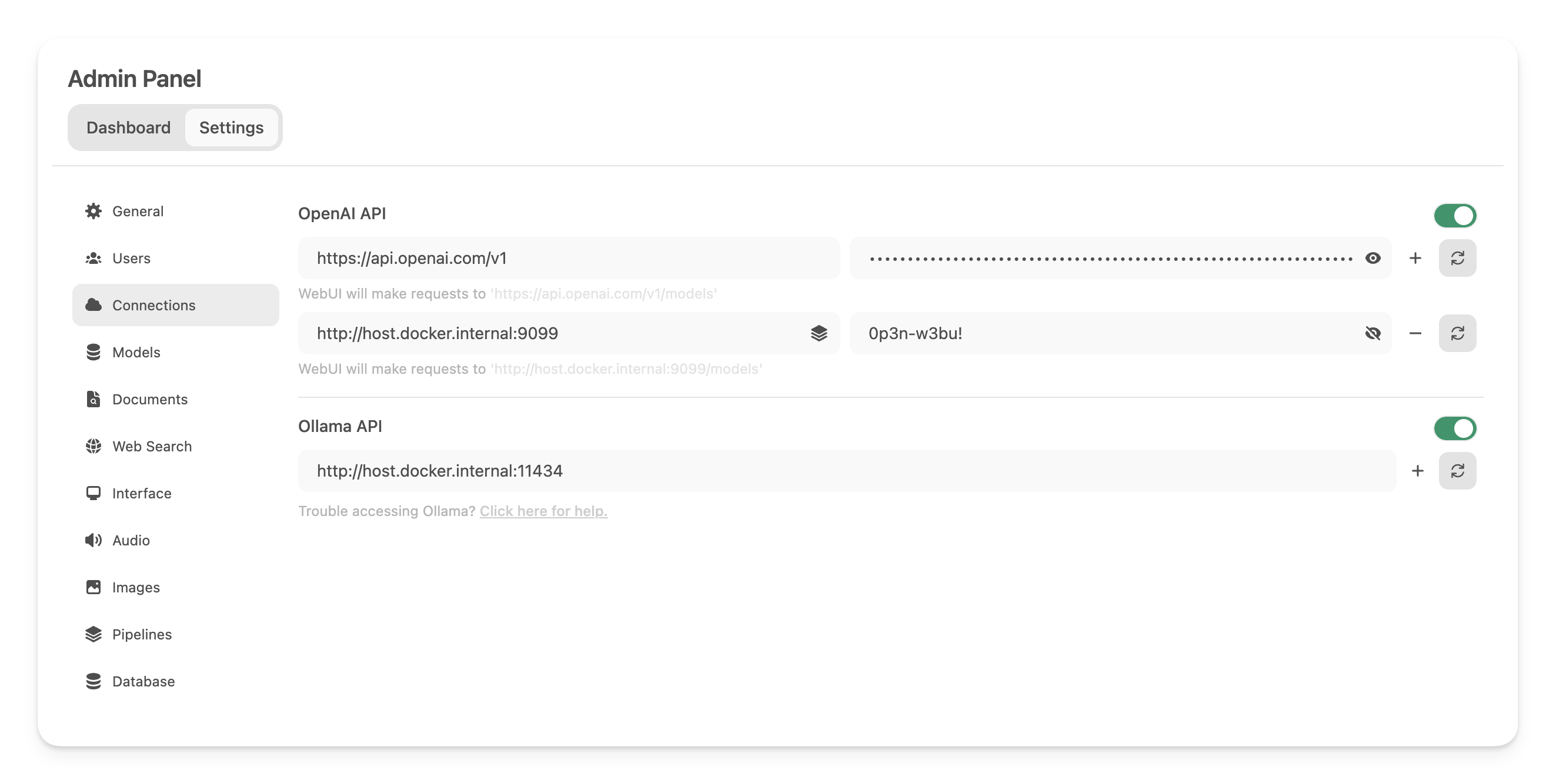

Nas Configurações de Administração, crie e salve uma nova conexão do tipo API OpenAI com os seguintes detalhes:

- URL:

http://host.docker.internal:9099(este é o local onde o contêiner Docker lançado anteriormente está sendo executado). - Senha: 0p3n-w3bu! (senha padrão)

Passo 4: Adicionar o Pipeline do Filtro Langfuse

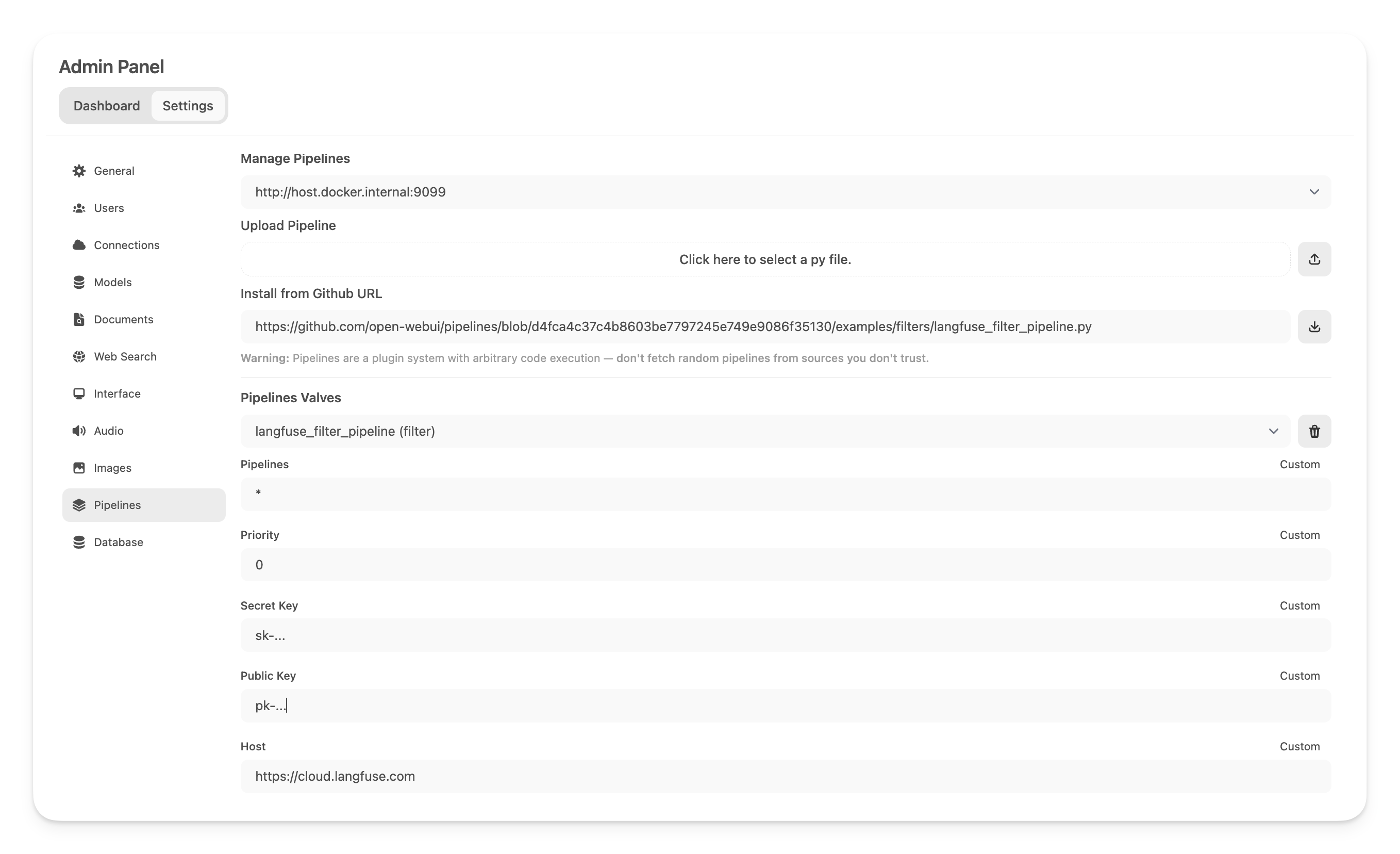

Em seguida, navegue para Configurações de Administração -> Pipelines e adicione o Pipeline do Filtro Langfuse. Especifique que o Pipelines está escutando emhttp://host.docker.internal:9099 (como configurado anteriormente) e instale o Pipeline do Filtro Langfuse usando a opção Instalar via URL do GitHub com o seguinte URL:

https://github.com/open-webui/pipelines/blob/main/examples/filters/langfuse_filter_pipeline.py

Agora, adicione suas chaves de API do Langfuse abaixo. Se você ainda não se inscreveu no Langfuse, pode obter suas chaves de API criando uma conta aqui.

Nota: Para capturar o uso (contagem de tokens) para modelos OpenAI enquanto o streaming está ativado, você deve navegar para as configurações do modelo no Open WebUI e marcar a caixa "Uso" aqui abaixo de Capacidades.

Passo 5: Ver seus rastreamentos no Langfuse

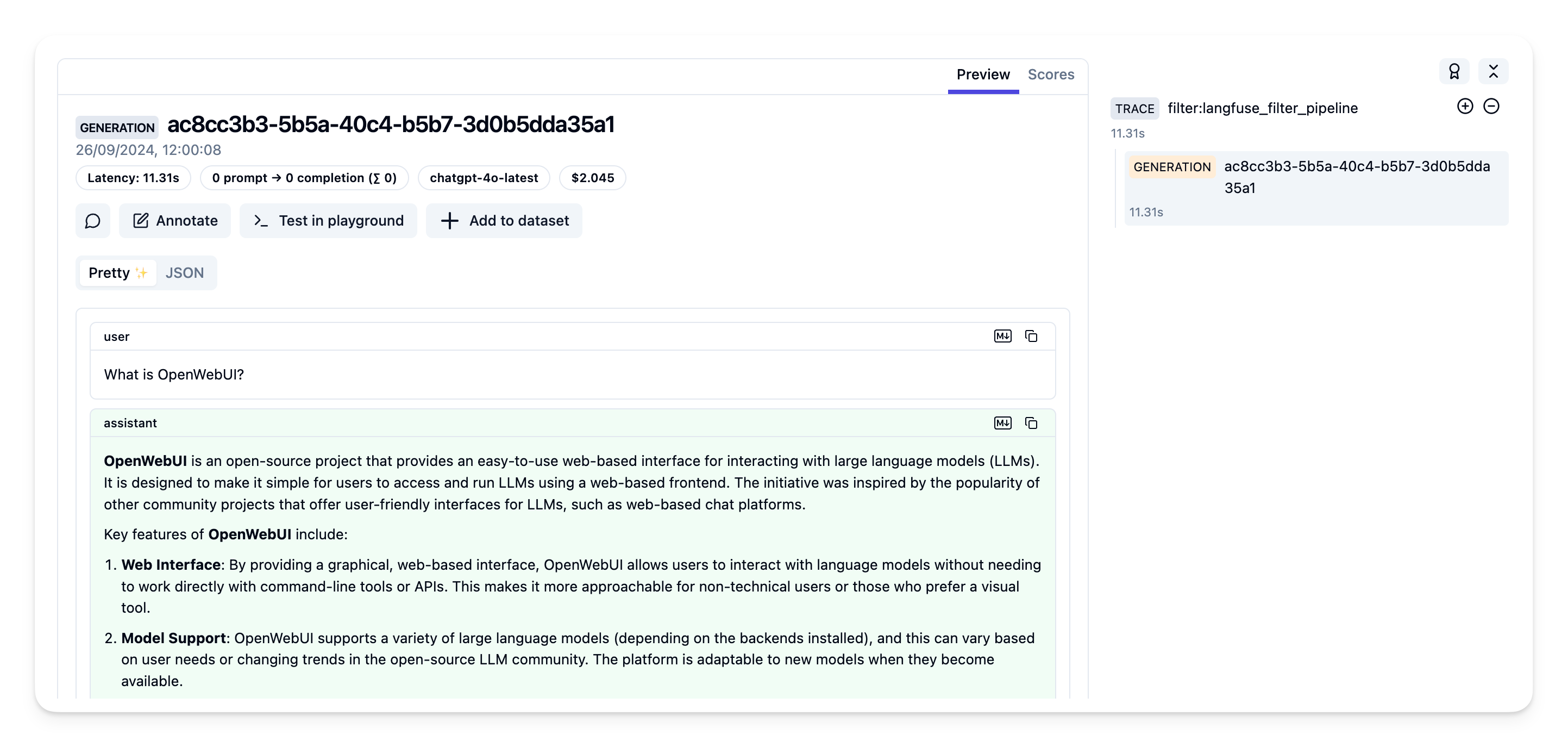

Agora você pode interagir com seu aplicativo Open WebUI e ver os rastreamentos no Langfuse.

Exemplo de rastreamento na interface do Langfuse:

Saiba mais

Para um guia abrangente sobre Pipelines do Open WebUI, visite este post.