Integración de Langfuse con Open WebUI

Langfuse (GitHub) ofrece observabilidad y evaluaciones de código abierto para Open WebUI. Al habilitar la integración con Langfuse, puedes rastrear los datos de tu aplicación con Langfuse para desarrollar, monitorear y mejorar el uso de Open WebUI, incluyendo:

- Trazas de la aplicación

- Patrones de uso

- Datos de costos por usuario y modelo

- Reproducción de sesiones para depurar problemas

- Evaluaciones

Cómo integrar Langfuse con Open WebUI

Pasos de integración de Langfuse

Pasos de integración de Langfuse

Pipelines en Open WebUI es un marco independiente de interfaz de usuario para plugins de la API de OpenAI. Permite la inyección de plugins que interceptan, procesan y reenvían solicitudes de usuario al LLM final, permitiendo un control y personalización mejorados del manejo de solicitudes.

Para rastrear los datos de tu aplicación con Langfuse, puedes usar el pipeline de Langfuse, que permite la monitorización y análisis en tiempo real de las interacciones de mensajes.

Guía Rápida

Paso 1: Configura Open WebUI

Asegúrate de tener Open WebUI en funcionamiento. Para hacerlo, revisa la documentación de Open WebUI.

Paso 2: Configura Pipelines

Inicia Pipelines utilizando Docker. Usa el siguiente comando para iniciar Pipelines:

docker run -p 9099:9099 --add-host=host.docker.internal:host-gateway -v pipelines:/app/pipelines --name pipelines --restart always ghcr.io/open-webui/pipelines:main

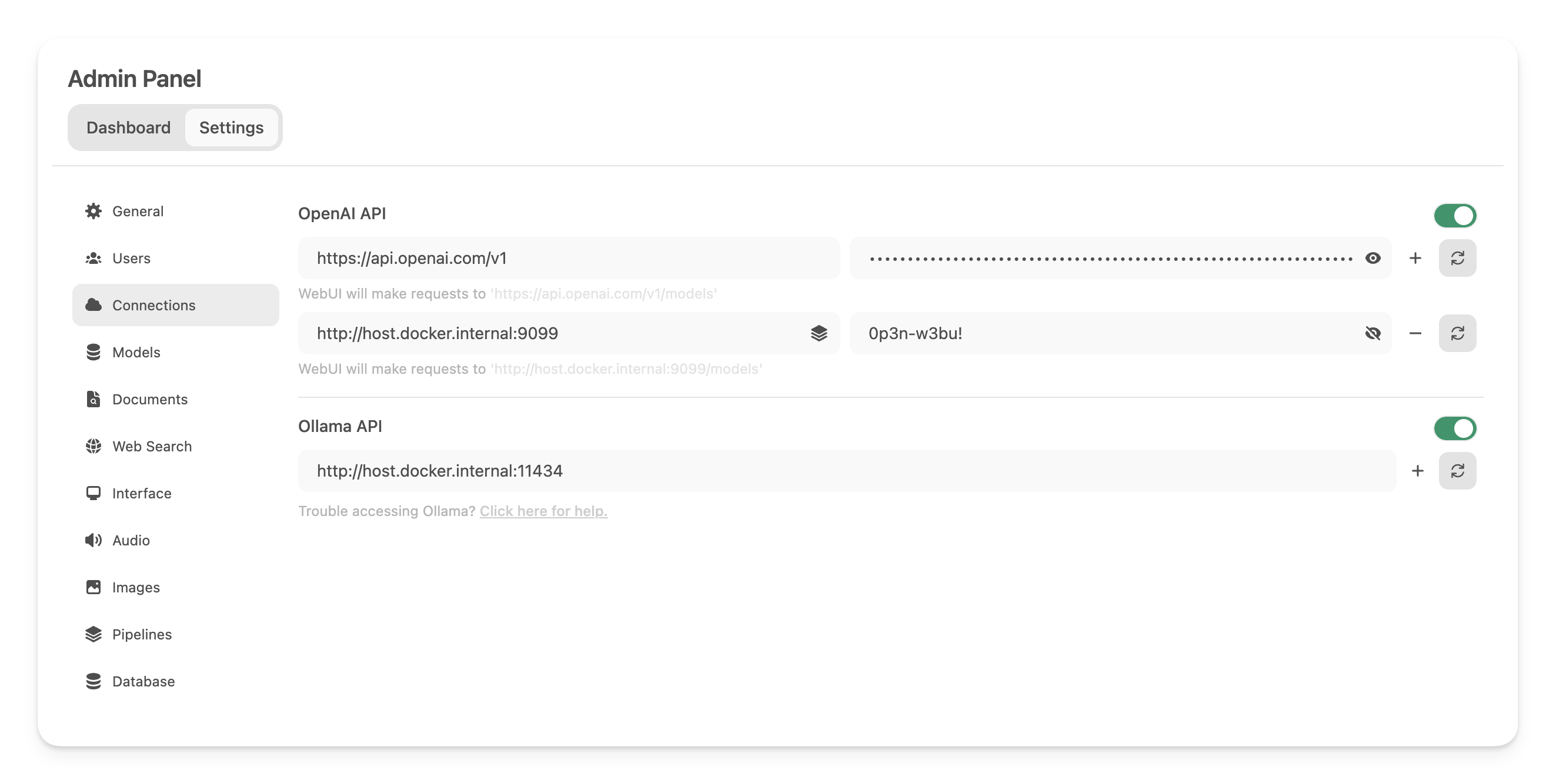

Paso 3: Conecta Open WebUI con Pipelines

En los Admin Settings, crea y guarda una nueva conexión de tipo API de OpenAI con los siguientes detalles:

- URL:

http://host.docker.internal:9099(aquí es donde está ejecutándose el contenedor Docker lanzado anteriormente). - Password: 0p3n-w3bu! (contraseña estándar)

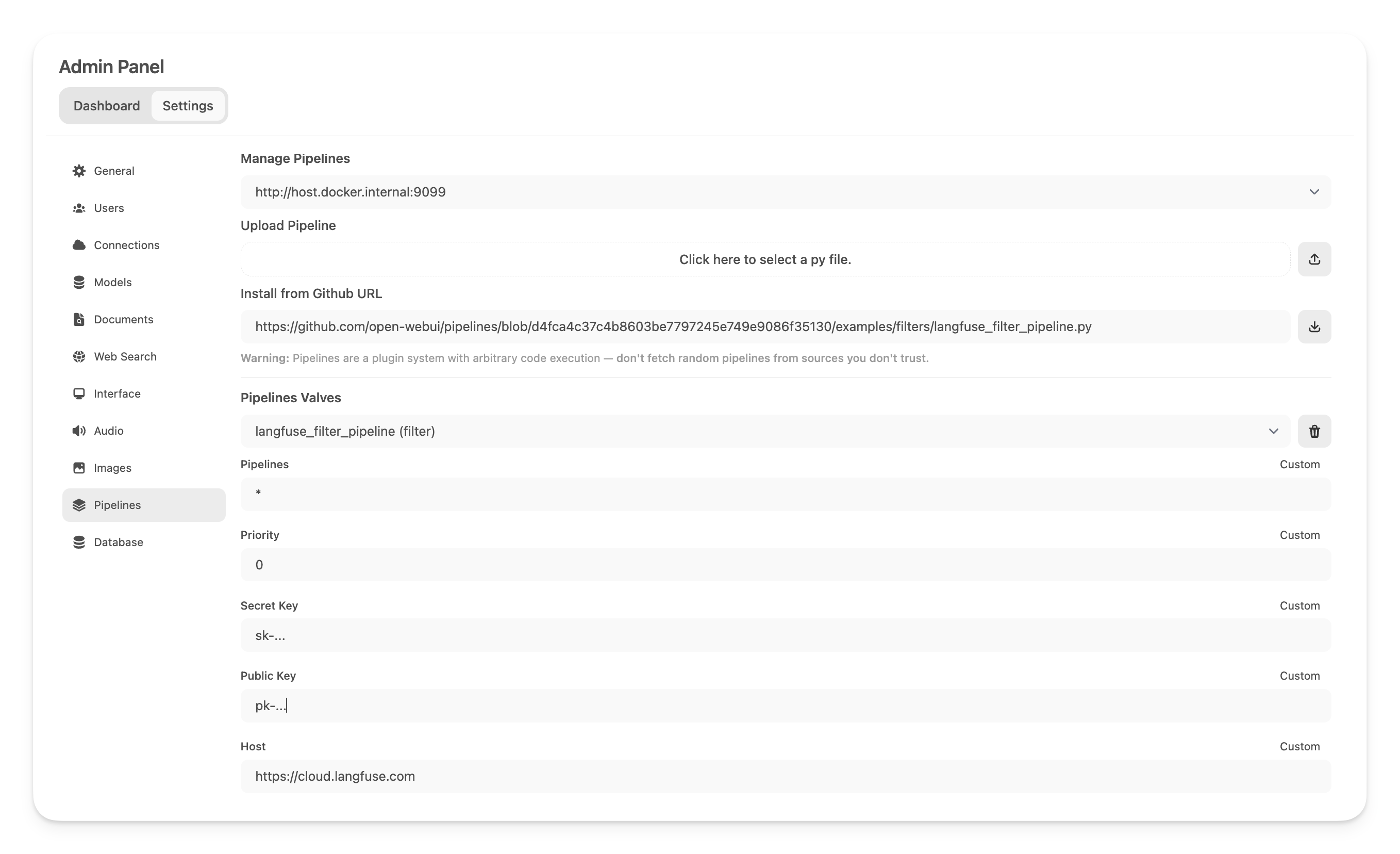

Paso 4: Agregar el Pipeline del Filtro de Langfuse

A continuación, dirígete a Admin Settings -> Pipelines y agrega el Pipeline del Filtro de Langfuse. Especifica que Pipelines está escuchando enhttp://host.docker.internal:9099 (como fue configurado previamente) e instala el Pipeline del Filtro de Langfuse usando la opción Install from Github URL con la siguiente URL:

https://github.com/open-webui/pipelines/blob/main/examples/filters/langfuse_filter_pipeline.py

Ahora, ingresa tus claves API de Langfuse a continuación. Si aún no te has registrado en Langfuse, puedes obtener tus claves API creando una cuenta aquí.

Nota: Para capturar el uso (conteo de tokens) de los modelos de OpenAI mientras la transmisión está habilitada, debes ir a la configuración del modelo en Open WebUI y marcar la casilla "Usage" aquí bajo Capabilities.

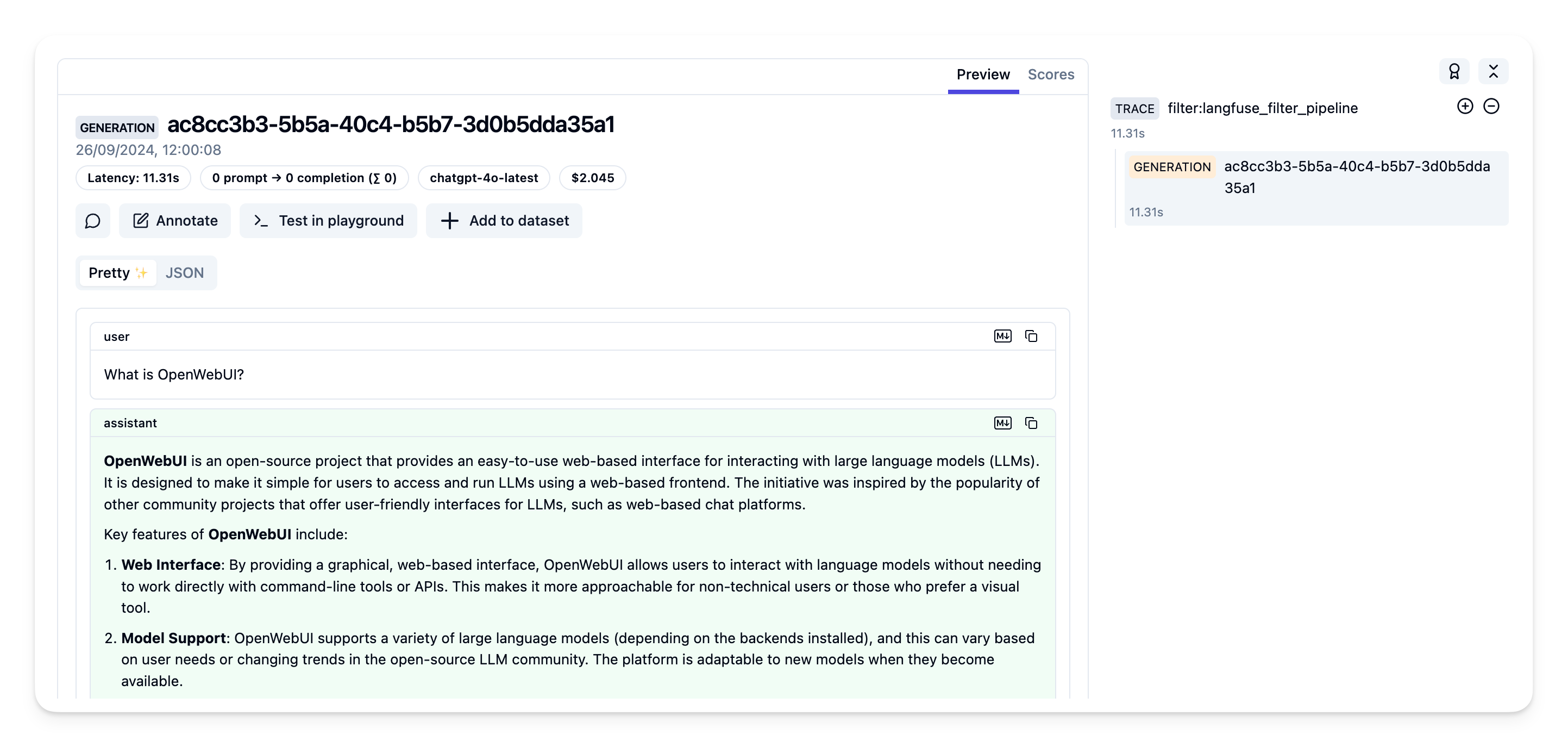

Paso 5: Visualiza tus trazas en Langfuse

Ahora puedes interactuar con tu aplicación Open WebUI y ver las trazas en Langfuse.

Traza de ejemplo en la interfaz de Langfuse:

Aprende más

Para una guía completa sobre Open WebUI Pipelines, visita este artículo.