このチュートリアルはコミュニティ貢献によるものであり、Open WebUIチームによって公式にサポートされているものではありません。特定のユースケースに合わせてOpen WebUIをカスタマイズする方法をデモンストレーションとして提供します。寄稿を希望する場合は、投稿チュートリアルをご覧ください。

Open WebUIとHeliconeの統合

Heliconeは、開発者向けに運用準備が整ったアプリケーションを監視、デバッグ、改善するためのオープンソースLLM可視化プラットフォームです。これには、Open WebUIデプロイメントが含まれます。

Heliconeを有効にすると、LLMリクエストをログし、プロンプトを評価・実験し、即時の洞察を得ることで、自信を持ってプロダクションへの変更を進めることができます。

- モデルタイプをまたぐ統合ビューによるリアルタイム監視: ローカルのOllamaモデルとクラウドAPIを一つのインターフェースで監視

- リクエストの視覚化と再実行: Open WebUIでどのプロンプトが各モデルに送信され、生成されたLLMの出力を評価可能

- ローカルLLM性能追跡: セルフホストされたモデルの応答時間とスループットを測定

- モデル別の利用分析: Open WebUIセットアップ内での異なるモデルの利用パターンを比較

- ユーザー分析: インタラクションパターンを理解

- デバッグ機能: モデルレスポンスの問題をトラブルシューティング

- コスト追跡: 各プロバイダーでのLLM利用の費用を追跡

Open WebUIとHeliconeを統合する方法

ステップ1: Heliconeアカウントを作成し、APIキーを生成

Heliconeアカウントを作成してログインし、こちらでAPIキーを生成。

— 書き込み専用APIキーを生成することをお勧めします。これにより、プライベートデータへの読み取りアクセスなしでHeliconeにログデータを送信するだけが許可されます。

ステップ2: OpenAIアカウントを作成し、APIキーを生成

OpenAIアカウントを作成し、OpenAIの開発者ポータルにログインしてAPIキーを生成。

ステップ3: HeliconeのベースURLを使用してOpen WebUIアプリケーションを実行

最初のOpen WebUIアプリケーションを起動するには、Open WebUIドキュメントのコマンドを使用し、HeliconeのAPI BASE URLを含めて、自動的にクエリと監視を行えるようにします。

# 環境変数を設定

export HELICONE_API_KEY=<YOUR_API_KEY>

export OPENAI_API_KEY=<YOUR_OPENAI_API_KEY>

# Helicone統合でOpen WebUIを実行

docker run -d -p 3000:8080 \

-e OPENAI_API_BASE_URL="https://oai.helicone.ai/v1/$HELICONE_API_KEY" \

-e OPENAI_API_KEY="$OPENAI_API_KEY" \

--name open-webui \

ghcr.io/open-webui/open-webui

既にOpen WebUIアプリケーションが展開されている場合は、 管理パネル > 設定 > 接続に移動し、「OpenAI API接続を管理」のための「+」記号をクリックします。次のプロパティを更新します:

APIベースURLはhttps://oai.helicone.ai/v1/<YOUR_HELICONE_API_KEY>APIキーはOpenAI APIキーです。

![]()

ステップ4: 監視が正常に機能していることを確認

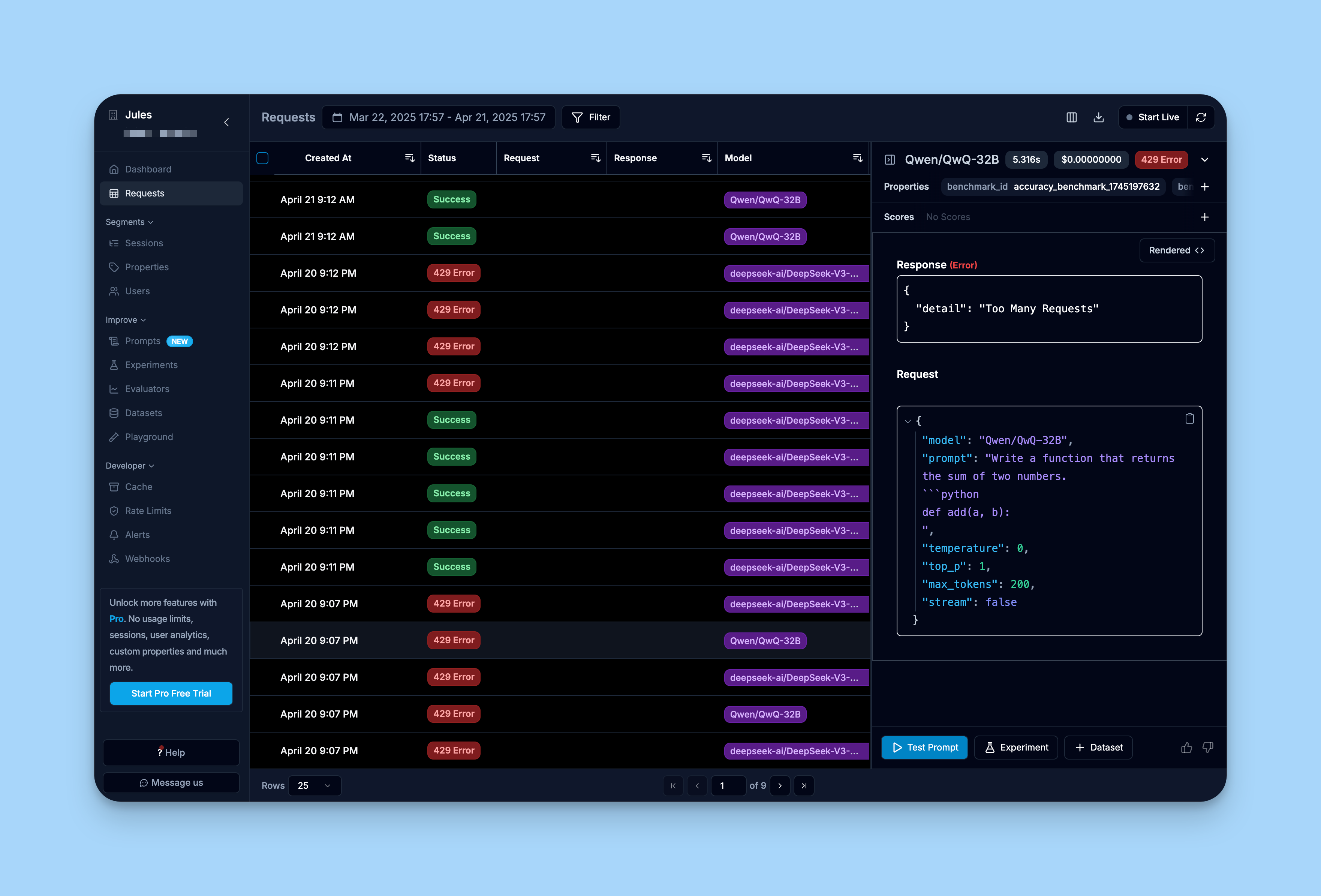

統合が正常に機能していることを確認するには、Heliconeのダッシュボードにログインし、「リクエスト」タブを確認します。

すでにOpen WebUIインターフェースを通じて行ったリクエストがHeliconeにログに記録されていることが確認できます。

詳細を学ぶ

Heliconeの包括的ガイドについては、こちらのHeliconeドキュメントをご覧ください。