🌐 OpenAI互換サーバーの使用を開始

概要��

Open WebUIはOpenAI/Ollama/Llama.cppだけのためではありません。 OpenAI互換APIを実装している任意のサーバー(ローカルまたはリモート)に接続できます。 これにより、異なる言語モデルを実行したり、既にお気に入りのバックエンドやエコシステムがある場合に最適です。このガイドでは以下を説明します:

- OpenAI互換サーバーのセットアップ(いくつかの人気オプションを使用)

- Open WebUIへの接続

- 今すぐチャットを開始

ステップ1:OpenAI互換サーバーを選択

OpenAI互換APIを提供する多くのサーバーやツールがあります。以下にいくつかの人気オプションを紹介します:

- Llama.cpp: 非常に効率的で、CPUおよびGPUで動作

- Ollama: 非常に使いやすくクロスプラットフォーム対応

- LM Studio: Windows、Mac、Linux用の充実したデスクトップアプリ

- Lemonade (ONNX TurnkeyML): NPU/iGPUアクセラレーションを備えた高速ONNXベースのバックエンド

ご自身のワークフローに最適なものを選択してください!

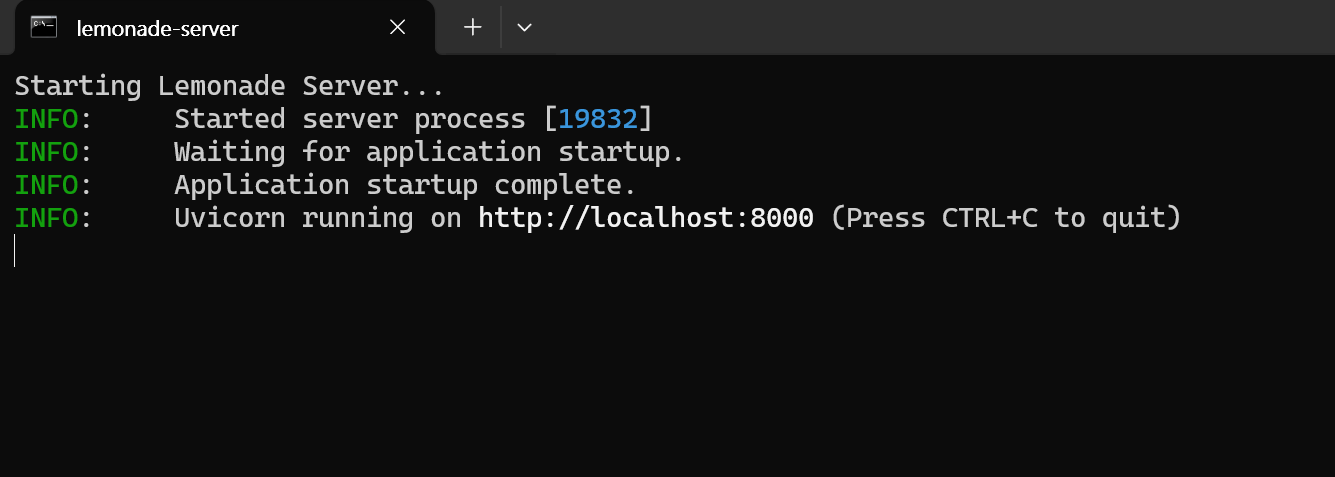

🍋 Lemonade (ONNX TurnkeyML)で始める

Lemonadeはプラグアンドプレイ型のONNXベースのOpenAI互換サーバーです。以下はWindowsで試す方法です:

-

Lemonade_Server_Installer.exeを実行 -

Lemonadeのインストーラーでモデルをインストールおよびダウンロード

-

実行中、APIエンドポイントは次のようになります:

http://localhost:8000/api/v0

詳細についてはドキュメントをご覧ください。

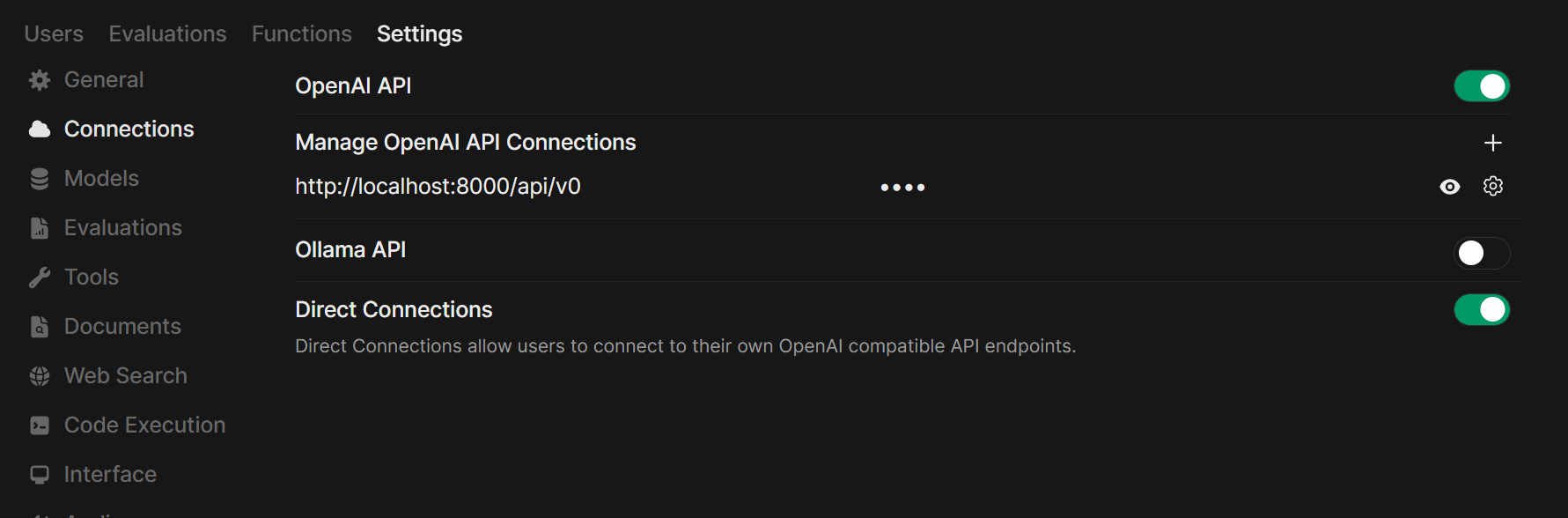

ステップ2:サーバーをOpen WebUIに接続

-

ブラウザでOpen WebUIを開く。

-

⚙️ 管理設定 → 接続 → OpenAI接続に進む。

-

➕ 接続を追加をクリック。

- URL: サーバーのAPIエンドポイントを使用(例:Ollamaの場合は

http://localhost:11434/v1、または自身のLlama.cppサーバーのアドレス)。 - APIキー: 必要でない限り空欄のまま。

- URL: サーバーのAPIエンドポイントを使用(例:Ollamaの場合は

-

保存をクリック。

ヒント: Open WebUIをDockerで実行し、モデルサーバーをホストマシンで実行している場合、http://host.docker.internal:<your-port>/v1を使用してください。

Lemonadeの場合: Lemonadeを追加する際は、URLとしてhttp://localhost:8000/api/v0を使用。

ステップ3:チャットを開始!

チャットメニューで接続したサーバーのモデルを選択し、開始します。

以上です!Llama.cpp、Ollama、LM Studio、またはLemonadeを選択しても、Open WebUIで複数のモデルサーバーを簡単に試して管理できます。

🚀 理想的なローカルAI環境の構築をお楽しみください!