🌐 Começando com Servidores Compatíveis com OpenAI

Visão Geral

Open WebUI não é apenas para OpenAI/Ollama/Llama.cpp—você pode conectar qualquer servidor que implemente a API compatível com OpenAI, rodando localmente ou remotamente. Isso é perfeito caso você queira usar diferentes modelos de linguagem ou já tenha um backend ou ecossistema favorito. Este guia mostrará como:

- Configurar um servidor compatível com OpenAI (com algumas opções populares)

- Conectá-lo ao Open WebUI

- Começar a conversar imediatamente

Etapa 1: Escolher um Servidor Compatível com OpenAI

Há muitos servidores e ferramentas que expõem uma API compatível com OpenAI. Aqui estão alguns dos mais populares:

- Llama.cpp: Extremamente eficiente, funciona em CPU e GPU

- Ollama: Super amigável e multiplataforma

- LM Studio: Aplicativo desktop completo para Windows/Mac/Linux

- Lemonade (ONNX TurnkeyML): Backend rápido baseado em ONNX com aceleração por NPU/iGPU

Escolha o que melhor se adapta ao seu fluxo de trabalho!

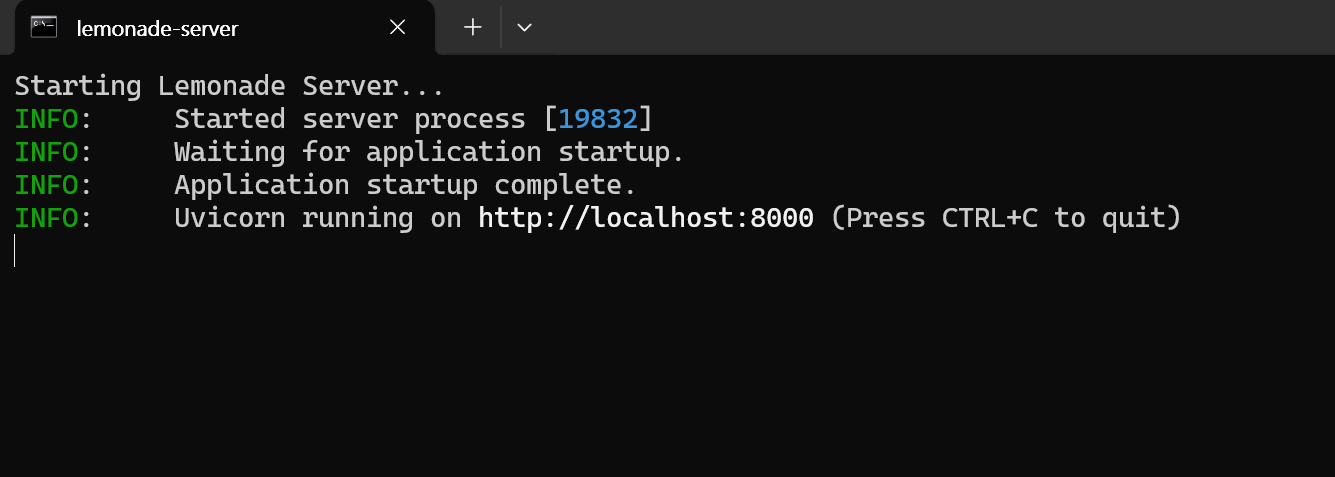

🍋 Começando com Lemonade (ONNX TurnkeyML)

Lemonade é um servidor compatível com OpenAI baseado em ONNX, pronto para uso. Veja como experimentá-lo no Windows:

-

Execute

Lemonade_Server_Installer.exe -

Instale e baixe um modelo usando o instalador do Lemonade

-

Uma vez em execução, o endpoint da API será:

http://localhost:8000/api/v0

Consulte a documentação para mais detalhes.

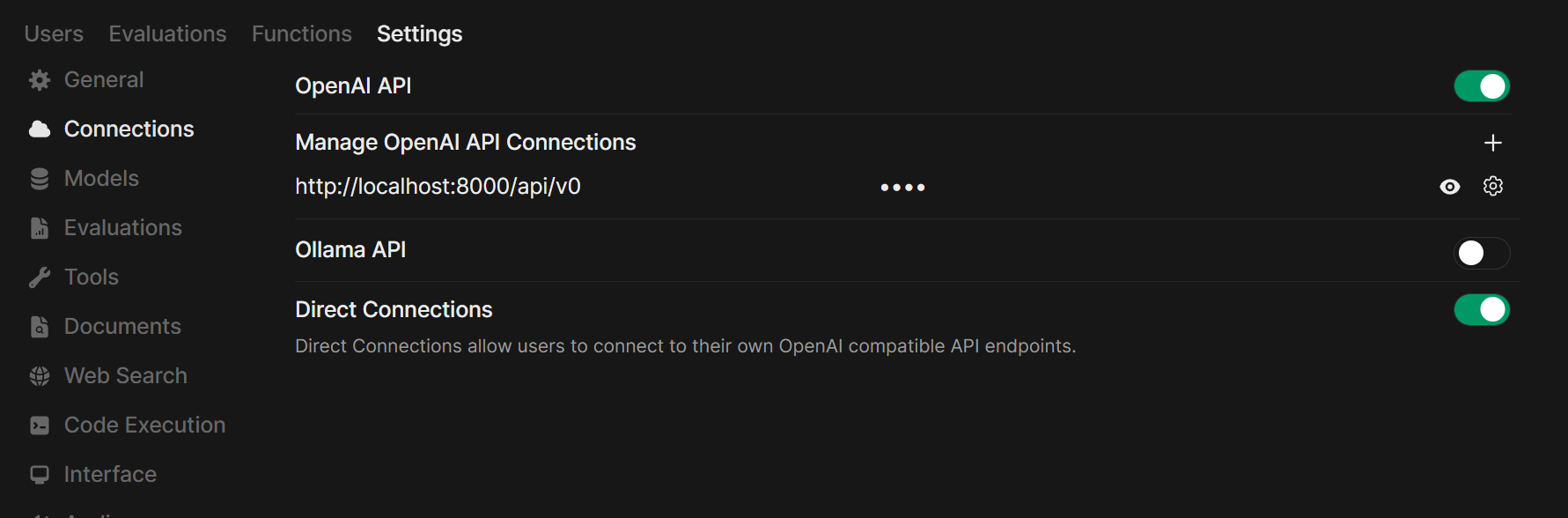

Etapa 2: Conecte seu Servidor ao Open WebUI

-

Abra o Open WebUI no seu navegador.

-

Vá para ⚙️ Configurações de Administração → Conexões → Conexões OpenAI.

-

Clique em ➕ Adicionar Conexão.

- URL: Use o endpoint da API do seu servidor (por exemplo,

http://localhost:11434/v1para Ollama, ou o endereço do seu próprio servidor Llama.cpp). - Chave API: Deixe em branco, a menos que seja necessário.

- URL: Use o endpoint da API do seu servidor (por exemplo,

-

Clique em Salvar.

Dica: Caso esteja executando Open WebUI no Docker e seu servidor de modelo na máquina host, use http://host.docker.internal:<sua-porta>/v1.

Para Lemonade: Ao adicionar o Lemonade, use http://localhost:8000/api/v0 como o URL.

Etapa 3: Comece a Conversar!

Selecione o modelo do seu servidor conectado no menu de bate-papo e comece!

É isso aí! Seja usando Llama.cpp, Ollama, LM Studio ou Lemonade, você pode experimentar e gerenciar facilmente vários servidores de modelos—tudo no Open WebUI.

🚀 Aproveite para criar sua configuração de IA local perfeita!