🌐 Начало работы с серверами, совместимыми с OpenAI

Обзор

Open WebUI предназначен не только для OpenAI/Ollama/Llama.cpp — вы можете подключить любой сервер, реализующий совместимый с OpenAI API, работающий локально или удаленно. Это идеально подходит, если вы хотите использовать различные языковые модели или если у вас уже есть любимый бэкэнд или экосистема. В этом руководстве вы узнаете:

- Как настроить сервер, совместимый с OpenAI (с несколькими популярными вариантами)

- Как подключить его к Open WebUI

- Как начать общение прямо сейчас

Шаг 1: Выберите сервер, совместимый с OpenAI

Существует множество серверов и инструментов, которые предоставляют API, совместимый с OpenAI. Вот некоторые из самых популярных:

- Llama.cpp: Экстремально эффективный, поддерживает работу на CPU и GPU

- Ollama: Удобный в использовании и кроссплатформенный

- LM Studio: Богатое настольное приложение для Windows/Mac/Linux

- Lemonade (ONNX TurnkeyML): Быстрый бэкэнд на основе ONNX с ускорением на NPU/iGPU

Выбирайте то, что лучше всего подходит для вашей работы!

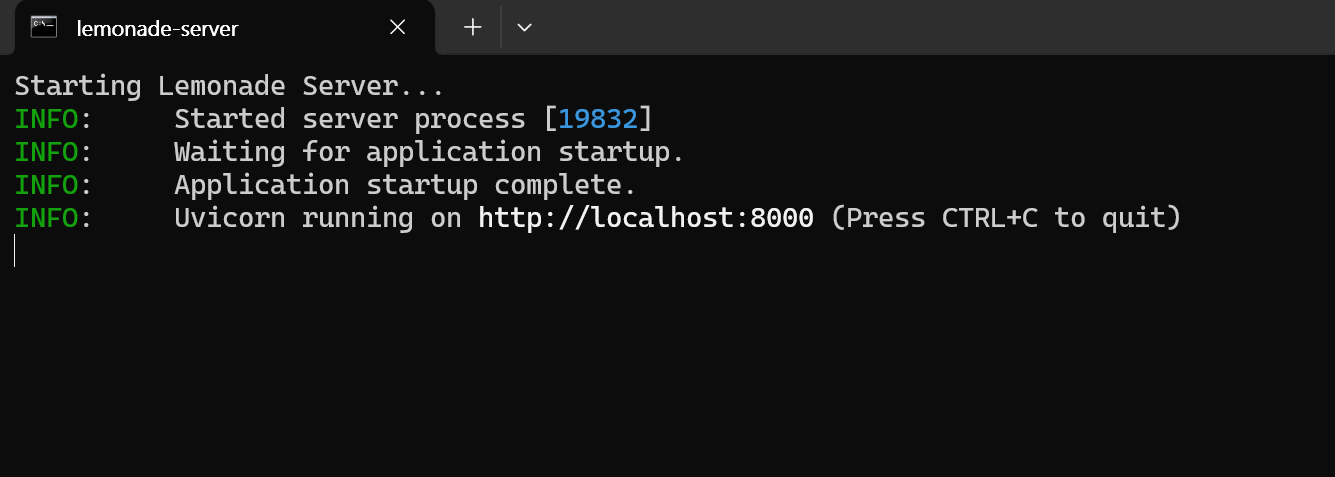

🍋 Начало работы с Lemonade (ONNX TurnkeyML)

Lemonade — это сервер, совместимый с OpenAI, который работает по принципу «подключи и работай» и основан на ONNX. Вот как попробовать его на Windows:

-

Запустите

Lemonade_Server_Installer.exe -

Установите модель и загрузите её с помощью установщика Lemonade

-

После запуска ваш API-эндпоинт будет:

http://localhost:8000/api/v0

См. документацию для деталей.

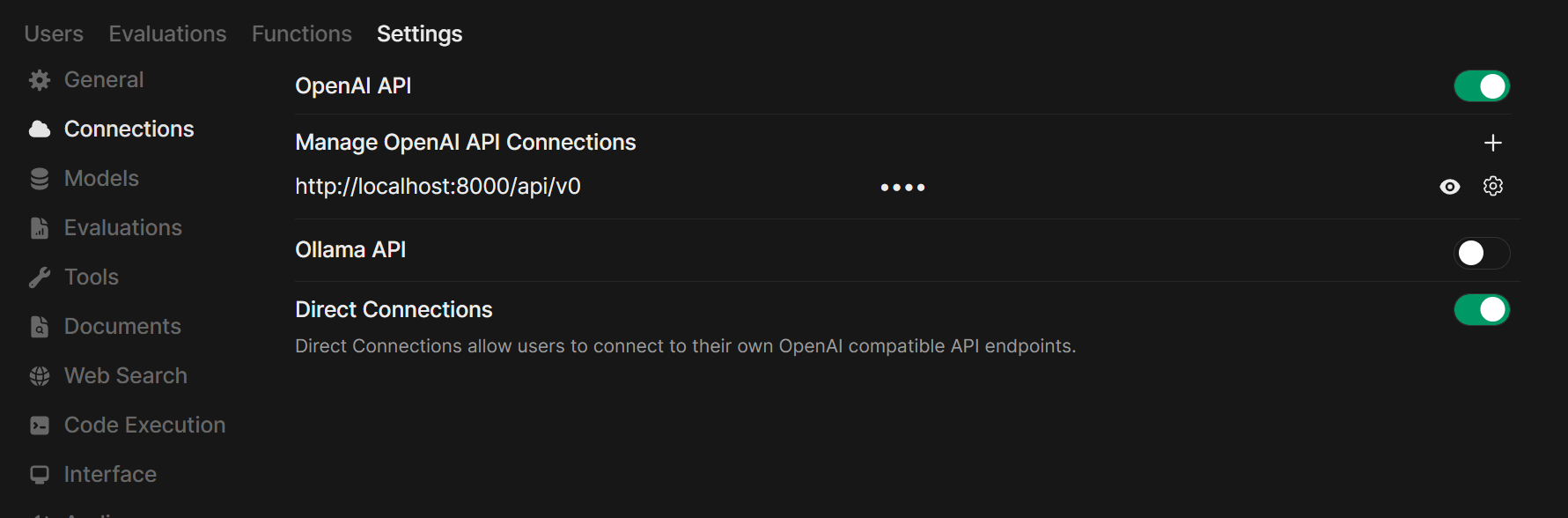

Шаг 2: Подключите сервер к Open WebUI

-

Откройте Open WebUI в браузере.

-

Перейдите в ⚙️ Настройки администратора → Подключения → Подключения OpenAI.

-

Нажмите ➕ Добавить подключение.

- URL: Используйте API-эндпоинт вашего сервера (например,

http://localhost:11434/v1для Ollama или адрес вашего сервера Llama.cpp). - Ключ API: Оставьте пустым, если не требуется.

- URL: Используйте API-эндпоинт вашего сервера (например,

-

Нажмите Сохранить.

Подсказка: Если вы запускаете Open WebUI в Docker, а сервер модели на вашем локальном компьютере, используйте http://host.docker.internal:<ваш-порт>/v1.

Для Lemonade: При добавлении Lemonade используйте http://localhost:8000/api/v0 в качестве URL.

Шаг 3: Начинайте общение!

Выберите модель вашего подключенного сервера в меню чата и начните работать!

Вот и всё! Независимо от того, выбираете ли вы Llama.cpp, Ollama, LM Studio или Lemonade, вы можете легко экспериментировать и управлять несколькими серверами моделей — всё в Open WebUI.

🚀 Приятного создания вашей идеальной локальной AI-настройки!